ComfyUI Stable Diffusion 3 to niezwykły postęp w renderowaniu opartym na sztucznej inteligencji. Szybko dodany do Stable Diffusion 3 ComfyUI jest częścią platformy i umożliwia użytkownikom tworzenie obrazów z wyjątkową dokładnością i autentycznością.

ComfyUI był popularnym wyborem wśród użytkowników poprzednich wersji Stable Diffusion, a płynne przejście do Stable Diffusion 3 (SD3) gwarantuje, że pozostanie w czołówce sceny artystycznej AI. Na tym blogu będziemy odkrywać zawiłości ComfyUI Stable Diffusion 3, jego funkcje i integrację z kreatywnymi przepływami pracy.

Przegląd ComfyUI Stable Diffusion 3

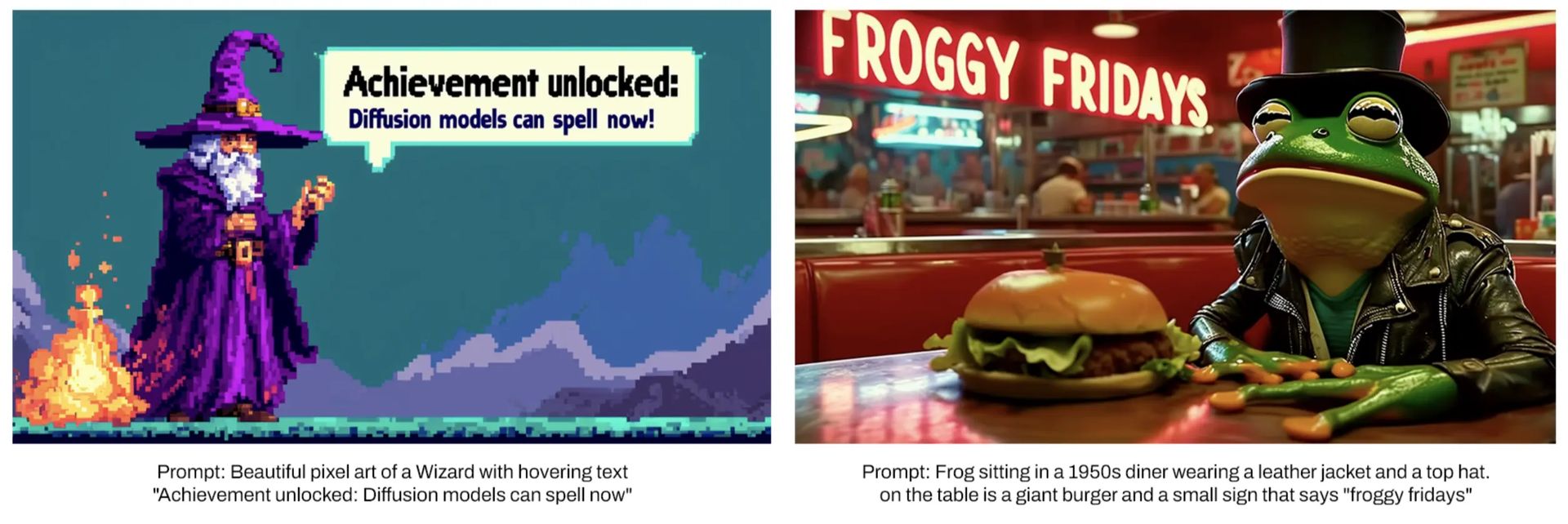

ComfyUI Stabilna dyfuzja 3 opiera się na fundamencie stworzonym przez swoich poprzedników, oferując użytkownikom potężne narzędzie do generowania obrazów z podpowiedzi tekstowych. Stable Diffusion 3 (SD3) został zaprojektowany, aby zapewnić większą dokładność, lepsze przestrzeganie podpowiedzi i doskonałą estetykę wizualną. Jest to możliwe dzięki złożonej architekturze, która dzieli przetwarzanie danych tekstowych i graficznych, tworząc bardziej szczegółowe i dopracowane wyniki. ComfyUI, znany z przyjaznego dla użytkownika interfejsu i solidnej wydajności, szybko dostosował się do integracji SD3, dzięki czemu jest dostępny dla różnych kreatywnych zastosowań.

Jedną z kluczowych cech ComfyUI Stable Diffusion 3 jest jego zdolność do obsługi złożonych komunikatów i tworzenia oszałamiających wizualnie wyników. Użytkownicy zaznajomieni z platformą docenią bezproblemową integrację SD3, która zachowuje znajomy tok pracy, jednocześnie poprawiając jakość i szczegółowość generowanych obrazów. Zmiana interfejsu wprowadzona przez ComfyUI pozwala również na bardziej intuicyjny i szczegółowy proces produkcji wizualnej, przypominający pracę z planami w oprogramowaniu takim jak Unity czy Unreal Engine.

Co więcej, przejście z modeli SDXL i Turbo do Stable Diffusion 3 podkreśla zaangażowanie platformy w bycie na bieżąco z postępem technologicznym. ComfyUI Stable Diffusion 3 nie tylko poprawia jakość wizualną generowanych obrazów, ale także oferuje większą swobodę twórczą w porównaniu do innych modeli AI, takich jak DALL·E lub Midjourney. To sprawia, że jest to preferowany wybór dla użytkowników, którzy chcą przesuwać granice sztuki generowanej przez sztuczną inteligencję.

Cud techniczny Architektura Stabilnej Dyfuzji 3

Architektura Multimodal Diffusion Converter (MMDiT), która koordynuje przetwarzanie i integrację podpowiedzi tekstowych i graficznych, jest mózgiem Stable Diffusion 3. W przeciwieństwie do wcześniejszych iteracji, które wykorzystywały jeden zestaw wag sieci neuronowej dla obu modalności, SD3 wykorzystuje inną wagę zestawy do obróbki obrazu i tekstu. To szczególne podejście znacznie poprawia wydajność modelu w zakresie rozumienia i postrzegania złożonych podpowiedzi, dając dokładniejsze i spójne wyniki.

Architektura MMDiT składa się z kilku kluczowych komponentów, które przyczyniają się do jej doskonałej wydajności. Narzędzia do osadzania tekstu, w tym dwa modele CLIP i T5, konwertują podpowiedzi tekstowe do formatu, który sztuczna inteligencja może skutecznie przetworzyć. Ulepszony model automatycznego kodowania służy jako koder obrazu, przekształcając obrazy w formę odpowiednią do manipulacji i generowania. Podejście z dwoma transformatorami, z odrębnymi transformatorami dla tekstu i obrazów, pozwala na bezpośrednią interakcję między modalnościami, zwiększając spójność i wierność generowanych obrazów.

Ta wyrafinowana konfiguracja umożliwia Stable Diffusion 3 osiągnięcie doskonałości w obszarach, w których poprzednie modele miały problemy. Oddzielna obsługa danych tekstowych i graficznych zapewnia dokładne uchwycenie niuansów złożonych podpowiedzi, co skutkuje wysokiej jakości wynikami wizualnymi, które są ściśle zgodne z instrukcjami użytkownika. To sprawia, że SD3 jest szczególnie skuteczny w projektach wymagających szczegółowego i precyzyjnego generowania obrazu.

Bezproblemowa integracja: korzystanie ze Stable Diffusion 3 z ComfyUI

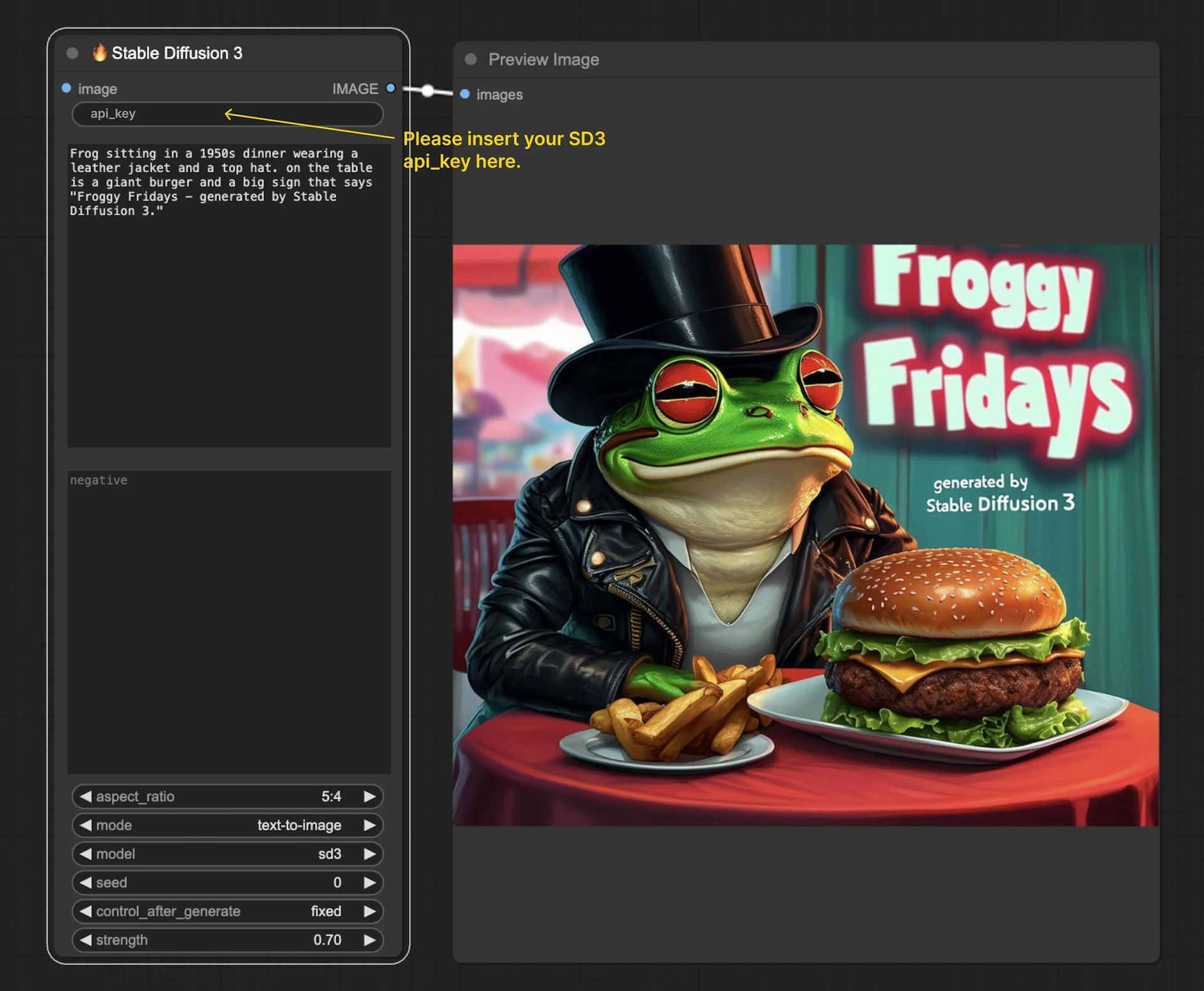

Przyjazna dla użytkownika konstrukcja Stable Diffusion 3 ułatwia integrację z przepływem pracy ComfyUI. RunComfy Beta zawiera preinstalowany węzeł SD3, co ułatwia klientom integrację z ich projektami. Procedura ma być możliwie bezproblemowa, redukująca potrzebę ręcznej instalacji i konfiguracji, niezależnie od tego, czy uruchamiasz zupełnie nowy projekt, czy włączasz SD3 do już ustalonego przepływu pracy.

Aby rozpocząć operację, użytkownicy muszą uzyskać plik Token API z platformy programistycznej Stability AI. Dzięki wersjom SD3 i SD3 Turbo dostępnym za pomocą tego klucza użytkownicy mogą generować obrazy w odpowiedzi na monity. Funkcje dostępne na platformie obejmują tryby przetwarzania tekstu na obraz i obrazu na obraz, konfigurowalne współczynniki proporcji oraz podpowiedzi pozytywne i negatywne. Korzystając z tych opcji, użytkownicy mogą dostosować proces generowania obrazu do własnych potrzeb.

Aby kontynuować, użytkownicy muszą najpierw otrzymać token API z platformy programistycznej Stability AI. Za pomocą tego klucza użytkownicy mogą robić zdjęcia w odpowiedzi na monity i uzyskiwać dostęp do wersji SD3 i SD3 Turbo. Platforma oferuje funkcje obejmujące kilka trybów przetwarzania tekstu na obraz i przetwarzania obrazu na obraz, a także zmienne współczynniki proporcji oraz podpowiedzi pozytywne i negatywne. Dzięki tym wyborom klienci mogą dostosować proces generowania obrazu do swoich wymagań.

Wygodny interfejs użytkownika Stabilna dyfuzja 3 jest przyjazny dla użytkownika i oferuje wiele sposobów instalacji, aby dostosować się do różnych konfiguracji sprzętu i systemów operacyjnych. Niezależnie od tego, czy korzystasz z systemu Windows, Linux czy macOS, użytkownicy mogą sprawdzić, czy platforma działa poprawnie, uzyskując dostęp do szczegółowych instrukcji instalacji na GitHubie. Ze względu na swoją dostępność ComfyUI jest elastycznym narzędziem, z którego może korzystać wielu użytkowników, od amatorów po profesjonalnych artystów.

Jak zainstalować ComfyUI: przewodnik krok po kroku

Integracja ComfyUI z Stabilna dyfuzja 3 (SD3) zapewnia przystępną platformę dla użytkowników chcących zbadać możliwości generowania obrazów w oparciu o sztuczną inteligencję. Ta sekcja przeprowadzi Cię przez proces instalacji, zapewniając bezproblemową konfigurację ComfyUI w swoim systemie. Instrukcje dotyczą różnych systemów operacyjnych, w tym Windows, Linux i macOS.

Przygotowanie systemu

Przed rozpoczęciem instalacji upewnij się, że system spełnia następujące wymagania:

- System operacyjny: Windows, Linux lub macOS.

- Pyton: Wersja 3.8 lub nowsza.

- CUDA: Wymagane do akceleracji GPU (w przypadku korzystania z procesora graficznego NVIDIA).

- Git: Do klonowania repozytorium z GitHub.

Upewnij się, że masz zainstalowane niezbędne sterowniki i oprogramowanie, szczególnie jeśli planujesz używać akceleracji GPU w celu szybszego przetwarzania.

Instalacja krok po kroku w systemie Windows

Zainstaluj Pythona i Gita:

- Pobierz i zainstaluj Pythona z oficjalna strona internetowa. Podczas instalacji pamiętaj o dodaniu języka Python do ścieżki PATH.

- Pobierz i zainstaluj Git z oficjalna strona internetowa.

Sklonuj repozytorium ComfyUI:

- Otwórz wiersz poleceń i przejdź do katalogu, w którym chcesz zainstalować ComfyUI.

- Uruchom następującą komendę, aby sklonować repozytorium:

Utwórz i aktywuj środowisko wirtualne:

- Uruchom następujące polecenia, aby utworzyć i aktywować środowisko wirtualne:

Zainstaluj wymagane zależności:

- Uruchom następujące polecenie, aby zainstalować niezbędne pakiety Pythona:

Skonfiguruj CUDA (w celu przyspieszenia GPU):

- Jeśli posiadasz procesor graficzny NVIDIA i chcesz używać CUDA do akceleracji, pobierz i zainstaluj CUDA zestaw narzędzi i cuDNN.

Uruchom ComfyUI:

- Uruchom serwer ComfyUI, uruchamiając:

- Otwórz przeglądarkę internetową i przejdź do `http://localhost:5000`, aby uzyskać dostęp do interfejsu ComfyUI.

Instalacja krok po kroku w systemie Linux

Zainstaluj Pythona i Gita:

- Zainstaluj Python i Git, korzystając z menedżera pakietów. Na przykład w Ubuntu uruchom:

Sklonuj repozytorium ComfyUI:

- Otwórz terminal i przejdź do katalogu, w którym chcesz zainstalować ComfyUI.

- Uruchom następującą komendę, aby sklonować repozytorium:

Utwórz i aktywuj środowisko wirtualne:

- Uruchom następujące polecenia, aby utworzyć i aktywować środowisko wirtualne:

Zainstaluj wymagane zależności:

- Uruchom następujące polecenie, aby zainstalować niezbędne pakiety Pythona:

Skonfiguruj CUDA (w celu przyspieszenia GPU):

- – Jeśli posiadasz procesor graficzny NVIDIA i chcesz używać CUDA do akceleracji, zainstaluj CUDA zestaw narzędzi i cuDNN postępując zgodnie z instrukcjami dla posiadanej dystrybucji Linuksa.

Uruchom ComfyUI:

- Uruchom serwer ComfyUI, uruchamiając:

- Otwórz przeglądarkę internetową i przejdź do `http://localhost:5000`, aby uzyskać dostęp do interfejsu ComfyUI.

Instalacja krok po kroku na macOS

Zainstaluj Pythona i Gita:

- zainstalować Domowe piwomenedżer pakietów dla systemu macOS.

- Użyj Homebrew, aby zainstalować Python i Git:

Sklonuj repozytorium ComfyUI:

- Otwórz terminal i przejdź do katalogu, w którym chcesz zainstalować ComfyUI.

- Uruchom następującą komendę, aby sklonować repozytorium:

Utwórz i aktywuj środowisko wirtualne:

- Uruchom następujące polecenia, aby utworzyć i aktywować środowisko wirtualne:

Zainstaluj wymagane zależności:

- Uruchom następujące polecenie, aby zainstalować niezbędne pakiety Pythona:

Uruchom ComfyU:

- Uruchom serwer ComfyUI, uruchamiając:

- Otwórz przeglądarkę internetową i przejdź do `http://localhost:5000`, aby uzyskać dostęp do interfejsu ComfyUI.

Wykonując poniższe kroki, możesz pomyślnie zainstalować ComfyUI w swoim systemie i rozpocząć odkrywanie możliwości Stable Diffusion 3. Ta konfiguracja pozwala wykorzystać zaawansowane funkcje SD3, z łatwością tworząc wysokiej jakości obrazy generowane przez sztuczną inteligencję. Niezależnie od tego, czy jesteś doświadczonym profesjonalistą, czy nowicjuszem w sztuce AI, ComfyUI Stable Diffusion 3 zapewnia solidną i przyjazną dla użytkownika platformę, dzięki której możesz urzeczywistnić swoje twórcze wizje.

Poza podstawami: Zaawansowane funkcje ComfyUI Stable Diffusion 3

Godną uwagi funkcją jest możliwość wykorzystania „planów” do produkcji wizualnej. Takie podejście pozwala użytkownikom tworzyć szczegółowe wizualizacje poprzez rozbicie obrazów na mniejsze elementy, takie jak kończyny w projekcie postaci. Użytkownicy mogą następnie wprowadzić określone zmiany w tych komponentach, uzyskując bardziej realistyczne i kreatywne obrazy.

Kolejną ważną funkcją jest obsługa różnych współczynników proporcji i trybów, zapewniając większą elastyczność w tworzeniu obrazu. Użytkownicy mogą wybierać spośród szerokiej gamy współczynników proporcji, aby dopasować się do wymagań projektu, a platforma obsługuje zarówno tryby zamiany tekstu na obraz, jak i obrazu na obraz. Ta wszechstronność gwarantuje, że ComfyUI Stable Diffusion 3 może być używany do różnorodnych kreatywnych zastosowań, od prostych ilustracji po złożone sceny.

Platforma zawiera również opcje zapewniające spójność generowanych obrazów, takie jak ustawienia „zalążkowe” i „parametry wytrzymałościowe”. Funkcje te pozwalają użytkownikom dostroić proces generowania obrazu, uzyskując spójne wyniki w wielu iteracjach. Ten poziom kontroli jest szczególnie przydatny w przypadku projektów wymagających jednolitości i precyzji, takich jak tworzenie serii powiązanych obrazów lub utrzymanie określonego stylu wizualnego.

Wygodny interfejs użytkownika Stabilna dyfuzja 3, który zapewnia użytkownikom większą dokładność, większą swobodę twórczą i lepszą jakość wizualną, to duży krok naprzód w renderowaniu opartym na sztucznej inteligencji. Integracja z platformą ComfyUI umożliwia korzystanie z różnych kreatywnych aplikacji, zapewniając bezproblemową i przyjazną użytkownikowi obsługę. Niezależnie od tego, czy jesteś doświadczonym artystą, czy początkującym w sztuce generowanej przez sztuczną inteligencję, ComfyUI stable diffusion 3 zapewnia narzędzia i funkcje potrzebne do urzeczywistnienia Twoich twórczych wizji.

Autor wyróżnionego obrazu: UruchomComfyUI