We współpracy z EleutherAI, LAION i StabilityAI opracowano model uczenia maszynowego tekstu na obraz, nazwany generatorem sztuki Stable Diffusion AI, w celu generowania obrazów cyfrowych na podstawie opisów w języku naturalnym.

Tworzenie sztuki przez AI nie jest niczym nowym. Jednak oprogramowanie takie jak DALL-E 2, Midjourney AI i Stable Diffusion wprowadzone w tym roku umożliwiło nawet najmniej wykwalifikowanym artystom tworzenie złożonych, abstrakcyjnych lub realistycznych dzieł sztuki, po prostu wprowadzając kilka słów w polu tekstowym.

Model generowania obrazu o otwartym kodzie źródłowym Stability AI jest na równi z DALL-E 2 pod względem jakości. Ponadto wprowadzono DreamStudio, komercyjną witrynę internetową, która zapewnia czas obliczeniowy do tworzenia obrazów Stable Diffusion. Stable Diffusion, w przeciwieństwie do DALL-E 2, może być używany przez każdego, a ponieważ kod jest open source, projekty mogą na nim bazować z niewielkimi ograniczeniami.

Co to jest generator sztuki Stable Diffusion AI?

Stability AI uruchomiło Stable Diffusion, generator sztuki AI o otwartym kodzie źródłowym, 22 sierpnia. Python jest używany do tworzenia Stable Diffusion i używana jest koncepcja języka transformatora. Każdy system operacyjny obsługujący jądra Cuda może z niego korzystać.

Dzięki paradygmatowi syntezy obrazu Stable Diffusion o otwartym kodzie źródłowym każdy, kto ma komputer PC i dobry procesor graficzny, może zbudować niemal każdą rzeczywistość wizualną, jaką może sobie wyobrazić. Może powielić praktycznie każdy styl wizualny, jeśli dodasz mu opisowy tekst, a wyniki cudownie pojawią się na ekranie.

W przeciwieństwie do metod takich jak DALL-E, Stable Diffusion udostępnia swój kod źródłowy. Licencja zabrania niektórych ryzykownych sytuacji użytkowania.

Etyka AI została zaatakowana przez przeciwników, którzy twierdzą, że model może być używany do tworzenia „głębokich podróbek” i kwestionują, czy właściwe jest tworzenie obrazów przy użyciu modelu wyszkolonego na zbiorze danych, który zawiera treści chronione prawem autorskim bez zgody artystów.

Zestaw szkoleniowy dla Stabilnej Dyfuzji był podzbiorem zestawu danych LAION-Aesthetics V2. Został przeszkolony na 256 procesorach graficznych Nvidia A100 w trybie zakupów za 600 000 USD.

Stability AI, firma, która wspiera stabilną dyfuzję, prowadzi rozmowy o pozyskaniu kapitału o wartości do 1 miliarda dolarów od września 2022 roku.

Wymagania dotyczące pobierania stabilnej dyfuzji

W 2022 r. typowy komputer do gier będzie obsługiwał stabilną dyfuzję, ale Twój telefon i większość laptopów nie. Wymagania wstępne dla pobrania Stable Diffusion, które musisz spełnić, są następujące:

- GPU z at najmniej 6 gigabajtów (GB) pamięci VRAM

- Obejmuje to większość nowoczesnych procesorów graficznych NVIDIA

- 10 GB (ish) miejsca na dysku twardym lub dysku SSD

- Instalator Miniconda3

- Pliki stabilnej dyfuzji z GitHub

- Najnowsze punkty kontrolne (wersja 1.4, w chwili pisania tego tekstu, ale wersja 1.5 powinna zostać wkrótce wydana)

- Instalator Git

- Windows 8, 10 lub 11

- Stabilną dyfuzję można również uruchomić w systemach Linux i macOS

Jak duży jest generator grafiki Stable Diffusion AI?

Potrzebujesz około 10 GB miejsca na dysku twardym lub dysku SSD.

Możesz wykorzystać W połowie drogi AI lub inne internetowe generatory AI, jeśli nie masz niezbędnego sprzętu.

Jak uruchomić generator grafiki Stable Diffusion AI?

Oto kroki, jak uruchomić generator grafiki Stable Diffusion AI:

- zainstalować Gita

- zainstalować Minikonda3

- Pobierz Stabilna dyfuzja repozytorium GitHub i Ostatni punkt kontrolny

Przyjrzyjmy się bliżej, jak możesz je wykonać.

Zainstaluj Gita

Programiści mogą zarządzać kilkoma wersjami oprogramowania, które tworzą za pomocą technologii zwanej Git. Mogą zachować różne wersje oprogramowania, nad którymi pracują, we wspólnym repozytorium, jednocześnie umożliwiając innym programistom udział w projekcie.

Jeśli nie jesteś programistą, Git zapewnia prosty sposób uzyskiwania dostępu do tych projektów i ich pobierania. Zastosujemy go w tej sytuacji. Prowadzenie Instalator Windows x64 które można pobrać ze strony internetowej Git, jest niezbędne do zainstalowania Git.

Podczas instalacji będziesz mieć możliwość ustawienia kilku opcji; pozostaw je wszystkie w ustawieniach domyślnych. Ważne jest, aby odwiedzić stronę opcji „Dostosowywanie środowiska PATH”. Należy wybrać tylko „Git z wiersza poleceń, a także z oprogramowania innych firm”.

Zainstaluj Minicondę3

Stable Diffusion korzysta z różnych bibliotek Pythona. Jeśli nie znasz Pythona, nie przejmuj się tym zbytnio; wystarczy, aby zrozumieć, że biblioteki to tylko pakiety oprogramowania, których komputer może używać do wykonywania określonych zadań, takich jak edycja obrazu lub wykonywanie trudnej arytmetyki.

Miniconda3 to zasadniczo wygodne narzędzie. Umożliwia zarządzanie każdą biblioteką wymaganą do działania stabilnego dyfuzji bez żmudnej pracy. Wpłynie to również na sposób, w jaki wykorzystujemy stabilną dyfuzję w rzeczywistych scenariuszach.

Odwiedzić Strona pobierania Miniconda3 i wybierz „Miniconda3 Windows 64-bit”, aby uzyskać najnowszą wersję.

Dwukrotne kliknięcie pliku wykonywalnego po pobraniu rozpocznie instalację. W porównaniu z Git instalacja Miniconda3 wymaga mniejszej liczby kliknięć w stronę. Należy jednak zachować ostrożność przy podejmowaniu tej decyzji:

Upewnij się, że wybrano opcję „Wszyscy użytkownicy” przed naciśnięciem następnego przycisku i zakończeniem instalacji.

Zostaniesz poproszony o ponowne uruchomienie komputera po zainstalowaniu Miniconda3 i Git.

Pobierz repozytorium Stable Diffusion GitHub i najnowszy punkt kontrolny

Po zainstalowaniu wymaganego oprogramowania możemy pobrać i skonfigurować Stable Diffusion.

Pobieranie Ostatni punkt kontrolny powinien być pierwszy. Aby pobrać punkt kontrolny, musisz najpierw utworzyć konto, ale wszystko, czego wymagają, to twoje imię i nazwisko oraz adres e-mail.

Link, który mówi „sd-v1-4.ckpt” rozpocznie pobieranie. Drugi plik, „sd-v1-4-full-ema.ckpt”, jest prawie dwa razy większy, ale może dać lepsze wyniki. Możesz użyć albo.

Następnym krokiem jest uzyskanie Stabilna dyfuzja z GitHuba. Wybierz zielony przycisk „Kod”, a następnie kliknij „Pobierz ZIP”. Możesz użyć ten bezpośredni link do pobrania również.

Teraz, gdy mamy już rozpakowane pliki Stable Diffusion, musimy utworzyć kilka katalogów, aby je rozpakować. Kliknij przycisk Start, wpisz “miniconda3” w polu wyszukiwania w menu Start, a następnie wybierz “Otwórz” lub “Enter”.

Za pomocą wiersza poleceń utworzymy folder o nazwie „stabilna dyfuzja”. Po wklejeniu następnej sekcji kodu do pola Miniconda3 naciśnij Enter.

Jeśli wszystko pójdzie zgodnie z planem, pojawi się okno Miniconda3. Nie zamykaj Miniconda3, ponieważ wkrótce będzie nam potrzebny.

Użyj swojego ulubionego archiwizatora plików, aby otworzyć archiwum ZIP „stable-diffusion-main.zip”, które pobrałeś z GitHub. System Windows może samodzielnie otwierać pliki ZIP jako alternatywę, jeśli ich nie masz. Trzymając plik ZIP otwarty w pierwszym oknie Eksploratora plików, otwórz drugie okno i przejdź do folderu “C: stabilne-dyfuzja”, który właśnie utworzyliśmy.

Przeciągnij i upuść folder „stable-diffusion-main” do folderu „stable-diffusion” z archiwum ZIP.

Wróć do Miniconda3 i wklej w oknie następujące polecenia:

cd C:stable-diffusionstable-diffusion-main conda env create -f environment.yaml conda activate ldm mkdir modelsldmstable-diffusion-v1

Kontynuuj procedurę. Ponieważ niektóre pliki są większe niż gigabit, pobieranie może zająć trochę czasu. Jeśli przypadkowo przerwasz proces, musisz usunąć folder środowiska i ponownie uruchomić conda env create -f environment.yaml. W tym scenariuszu, po usunięciu folderu „ldm” z „C: Users (Twoje konto użytkownika).condaenvs”, wykonaj poprzednie polecenie.

Ostatni etap instalacji został zakończony. Korzystając z Eksploratora plików, skopiuj plik punktu kontrolnego (sd-v1-4.ckpt) i wklej go do folderu „C:stable-diffusionstable-diffusion-mainmodelsldmstable-diffusion-v1”.

Kliknij prawym przyciskiem myszy “sd-v1-4.ckpt” po zakończeniu przesyłania pliku i wybierz “Zmień nazwę” z menu kontekstowego. Wpisz „model.ckpt” w podświetlonym polu i naciśnij Enter, aby zmienić nazwę pliku.

Już z tym skończyliśmy. Stabilna dyfuzja jest teraz dostępna do użytku. Ale jak?

Poradnik Stable Diffusion: Jak korzystać z generatora grafiki Stable Diffusion AI?

Jak działa stabilna dyfuzja? Wykonaj następujące kroki, aby jak najlepiej wykorzystać generator grafiki Stable Diffusion AI:

- Aktywuj środowisko ldm

- Zmień katalog

- Użyj txt2img.py i napisz swój tekst

- Poczekaj na proces

- Sprawdź wyniki

Za każdym razem, gdy chcesz korzystać ze stabilnej dyfuzji, musisz aktywować zaprojektowane przez nas środowisko ldm. Wpisz conda aktywuj ldm w oknie Miniconda3 i naciśnij „Enter”. Aktywne środowisko ldm jest oznaczone symbolem (ldm) po lewej stronie.

Musimy najpierw zmienić katalog (a więc commandcd) na „C:stable-diffusionstable-diffusion-main”, zanim będziemy mogli utworzyć jakiekolwiek zdjęcia. Dodaj parametr wiersza poleceń cd C:stable-diffusionstable-diffusion-main.

Konwertujemy podpowiedzi tekstowe na wizualizacje 512512 za pomocą narzędzia o nazwie txt2img.py.

Podczas generowania zdjęć zobaczysz pasek postępu na konsoli.

“C:stable-diffusionstable-diffusion-mainoutputstxt2img-samplessamples” to lokalizacja wszystkich wyprodukowanych obrazów.

Przykłady i podpowiedzi dotyczące stabilnej dyfuzji

Oto niektóre z najlepszych przykładów generatora grafiki Stable Diffusion AI i ich podpowiedzi:

Podpowiedź: leśny wędrowiec dominica mayera, anthony jones, Loish, styl malarski Geralda parela, craig mullins, marc simonetti, mike mignola, ilustracja w płaskich kolorach, jasny i kolorowy, wysoki kontrast, mitologia, kinowy, szczegółowy, atmosferyczny, epicki, grafika koncepcyjna, Malowanie matowe, Władca pierścieni, Gra o Tron, snopy światła, mgła, , fotorealistyczna, grafika koncepcyjna, światło wolumetryczne, kinowa epopeja + zasada trójpodziału | 35mm| renderowanie oktanowe, 8k, renderowanie koronowe, grafika koncepcyjna filmu, renderowanie oktanowe, 8k, renderowanie koronowe, cinematic, trending on artstation, grafika koncepcyjna filmu, kompozycja filmowa , bardzo szczegółowy, realistyczny , hiperealistyczny , oświetlenie wolumetryczne , 8k –ar 3:1 – test – światło w górę

Podpowiedź: Otoczenie zamku nathria w World of Warcraft ::styl gotycki w pełni rozwinięty zamek:filmowy, deszczowy, nocny, szczegółowy, epicki, grafika koncepcyjna, matowe malowanie, snopy światła, mgła, fotorealistyczny, grafika koncepcyjna, światło wolumetryczne, kinowa epopeja + reguła osób trzecich, grafika koncepcyjna filmu, 8k, filmowa, zyskująca popularność na artstation, grafika koncepcyjna filmu, kompozycja filmowa , bardzo szczegółowe, realistyczne , hiperrealistyczne , oświetlenie wolumetryczne , 8k – ar 3:1

Podpowiedź: wyraźny portret koncepcji superbohatera pomiędzy Spidermanem a Batmanem, Cottagecore!!, tło bardzo szczegółowe, koncepcja postaci, całe ciało, dynamiczna poza, skomplikowane, bardzo szczegółowe, cyfrowe malarstwo, artstation, grafika koncepcyjna, płynna, ostra ostrość, ilustracja, sztuka autorstwa artgerm i greg rutkowski i alphonse mucha

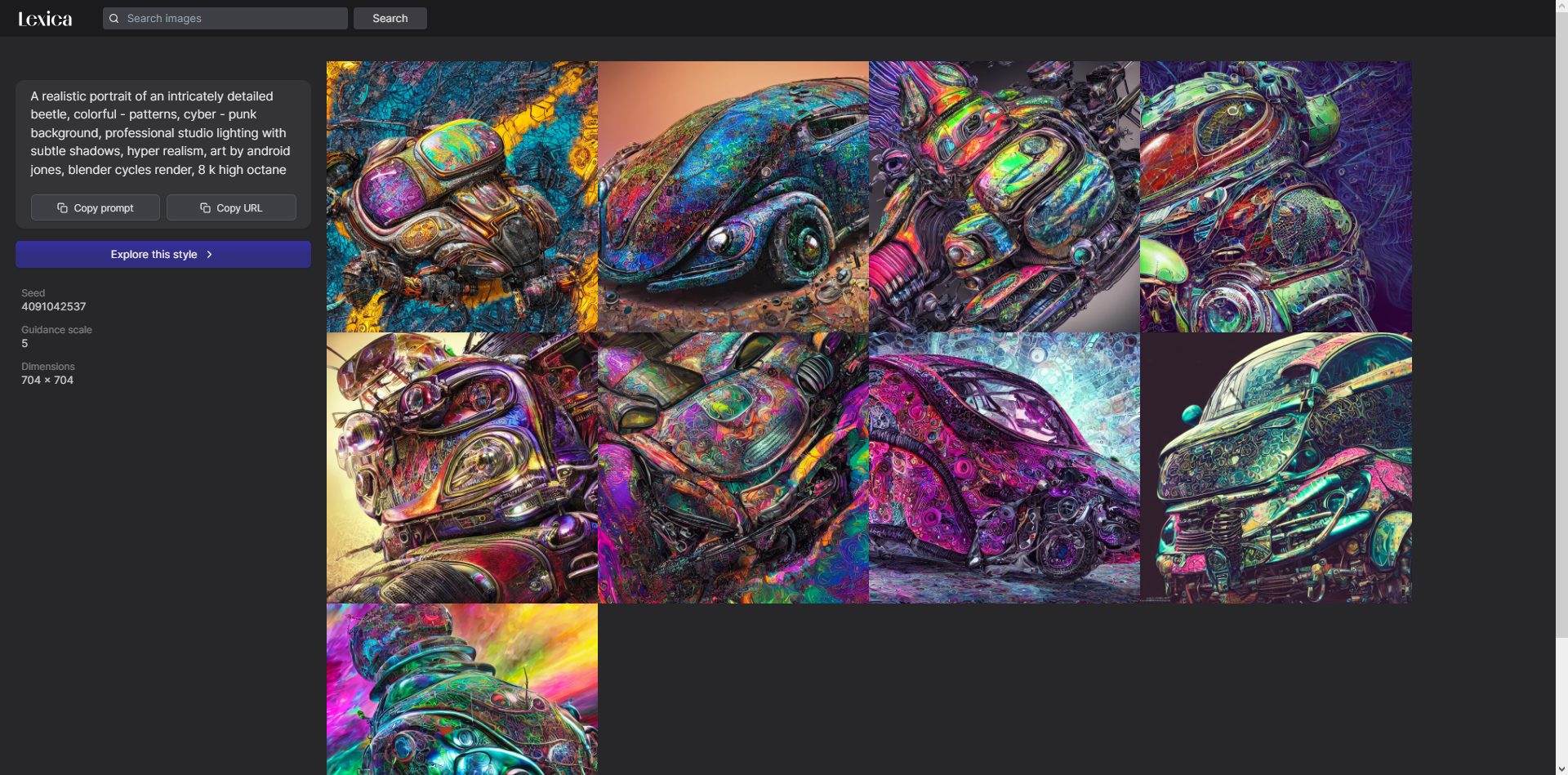

Czym jest Lexica Art?

Lexica to galeria i wyszukiwarka dzieł sztuki stworzonych za pomocą Stable Diffusion.

Możesz sprawdzić Leksyka, witryna internetowa dla wyszukiwarki, która wykorzystuje obrazy generowane przez sztuczną inteligencję ze stabilnej dyfuzji. Lexica zawiera monity o automatycznie generowane obrazy.

Czy stabilna dyfuzja jest open source?

TAk. Obrazy użyte w Stable Diffusion, która była open source 22 sierpnia, zostały utworzone przez sieć neuronową, która została wytrenowana na milionach obrazów pobranych z Internetu.

Niedawno pojawił się nowy rywal dla DALL-E i Midjourney AI. Przede wszystkim jest bezpłatny! Zobaczymy, jak konflikty generatora sztuki AI wpływają na rzeczy.

Source: Generator grafiki Stable Diffusion AI: podpowiedzi, przykłady i sposób uruchamiania