Zwiastun Megalopolis jest w tarapatach po tym, jak ujawniono, że niektóre z cytatów z recenzji były fałszywe i generowane przez sztuczną inteligencję. Eddie Egan, który odpowiadał za marketing zwiastuna, został usunięty ze swojego stanowiska z powodu tego bałaganu.

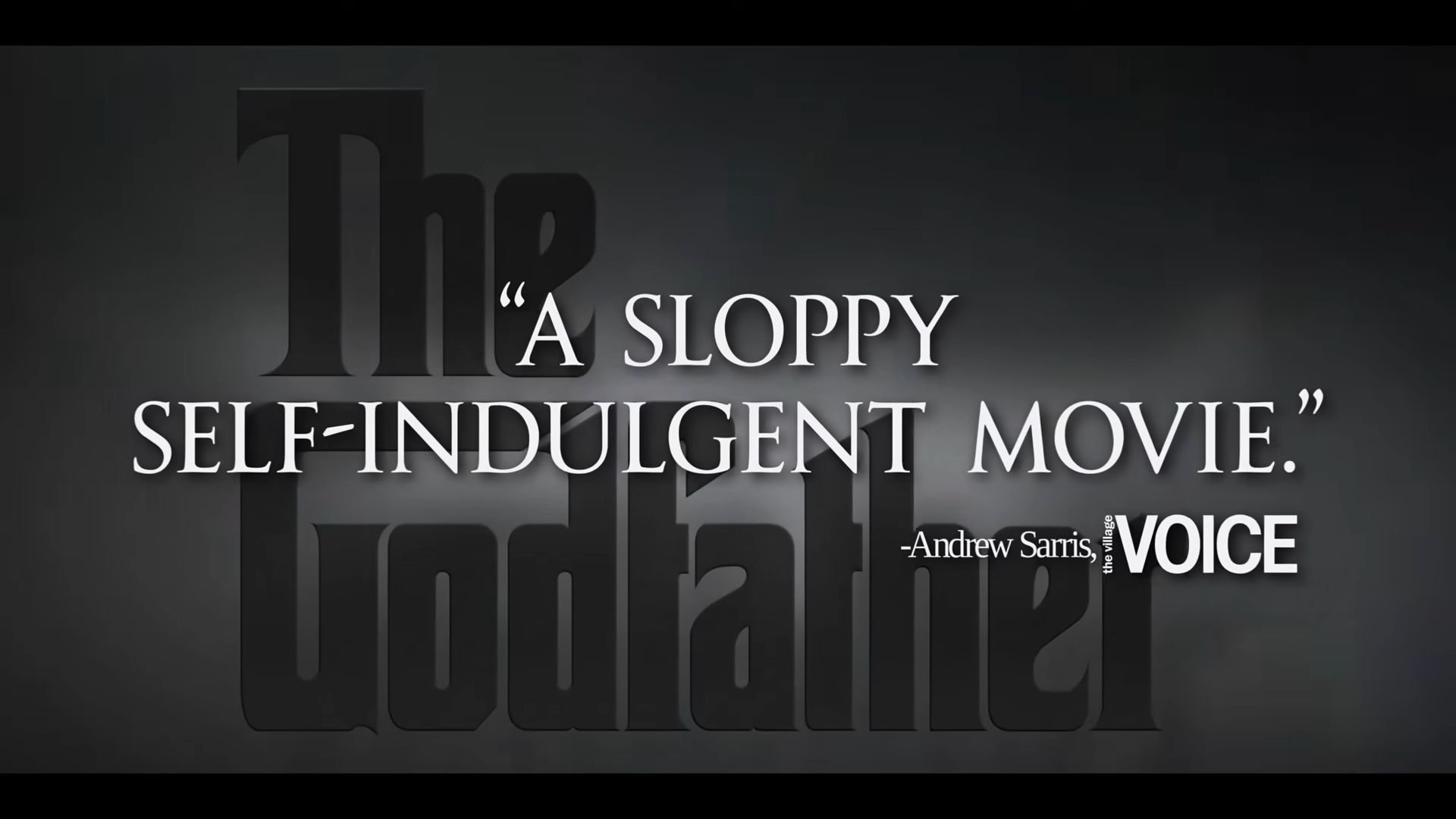

Zwiastun zawierał wymyślone recenzje krytykujące klasyczne filmy Francisa Forda Coppoli. Fałszywie twierdził, że „Ojciec chrzestny” był „niedbałym, samouwielbiającym filmem”, a „Czas apokalipsy” „epickim kawałkiem śmieci”. W rzeczywistości oryginalne recenzje były pozytywne i chwaliły filmy.

Ta sytuacja uwypukla rosnący problem z AI: może ona mieć halucynacje. Nie jest to problem tylko zwiastunów filmowych; błędy AI wpłynęły również na dokumenty prawne i sprawy sądowe. Na przykład prawnik Michaela Cohena przedstawił fałszywe sprawy sądowe, a prawnicy kolumbijskich linii lotniczych popełnili podobne błędy. Nawet raper Pras Michél przegrał sprawę sądową, ponieważ jego prawnik użył argumentu wygenerowanego przez AI.

Czym są halucynacje AI? Skandal z przyczepą Megalopolis pokazuje, jak działają

Halucynacje AI występują, gdy sztuczna inteligencja generuje informacje, które brzmią przekonująco, ale w rzeczywistości są fałszywe lub mylące. Skandal związany ze zwiastunem „Megalopolis” sprawił, że termin ten znalazł się w centrum uwagi.

W tym przypadku zwiastun zawierał fałszywe cytaty z recenzji filmów Francisa Forda Coppoli, twierdząc, że „Ojciec chrzestny” był „niedbały”, a „Czas apokalipsy” był „epickim śmieciem”. Sztuczna inteligencja stworzyła te cytaty, ale nie pasowały one do rzeczywistych pozytywnych recenzji tych filmów. Sztuczna inteligencja „wytworzyła halucynacje” na podstawie tych cytatów, tworząc wiarygodne, ale fałszywe stwierdzenia.

Halucynacje AI zdarzają się, ponieważ technologia może generować tekst na podstawie wzorców, których nauczyła się z danych, ale tak naprawdę nie rozumie treści. Może mieszać fakty, tworzyć błędy lub całkowicie zmyślać, co miało miejsce w przypadku wprowadzających w błąd recenzji w zwiastunie.

Ten incydent uwypukla ryzyko polegania na sztucznej inteligencji bez odpowiednich kontroli. Podobnie jak w przypadku „Megalopolis”, gdzie fałszywe cytaty doprowadziły do poważnych konsekwencji dla zaangażowanych osób, halucynacje sztucznej inteligencji mogą powodować zamieszanie i szkody, jeśli nie są ostrożnie zarządzane. Przypomina to, że chociaż sztuczna inteligencja może być potężna, kluczowe jest weryfikowanie jej wyników, aby uniknąć wprowadzających w błąd informacji.

Źródło wyróżnionego obrazu: Baza danych IMDb

Source: Jeśli będziesz tak używać sztucznej inteligencji, stracisz pracę