Najnowszy raport firmy ochroniarskiej PromptArmor ujawnił poważny problem ze Slack AI, narzędziem, które pomaga użytkownikom w takich zadaniach, jak podsumowywanie konwersacji i wyszukiwanie informacji w Slacku. Problem polega na tym, że Slack AI ma lukę w zabezpieczeniach, która może spowodować wyciek prywatnych danych z kanałów Slacka.

Jaki jest problem?

Slack AI ma ułatwiać pracę poprzez podsumowywanie czatów i odpowiadanie na pytania przy użyciu danych ze Slacka. Jednak PromptArmor odkrył, że AI jest podatna na coś, co nazywa się wstrzykiwaniem błyskawicznego impulsu. Oznacza to, że atakujący mogą oszukać AI, aby ujawniła informacje, których nie powinna.

Jak działa natychmiastowy zastrzyk?

Prompt injection to metoda używana do manipulowania zachowaniem SI. Oto jak to działa:

- Złośliwy monit: Atakujący tworzy monit (rodzaj polecenia), który oszukuje sztuczną inteligencję.

- Dostęp do danych: Monit ten może spowodować, że sztuczna inteligencja zacznie pobierać dane z kanałów, do których atakujący nie powinien mieć dostępu, w tym z kanałów prywatnych.

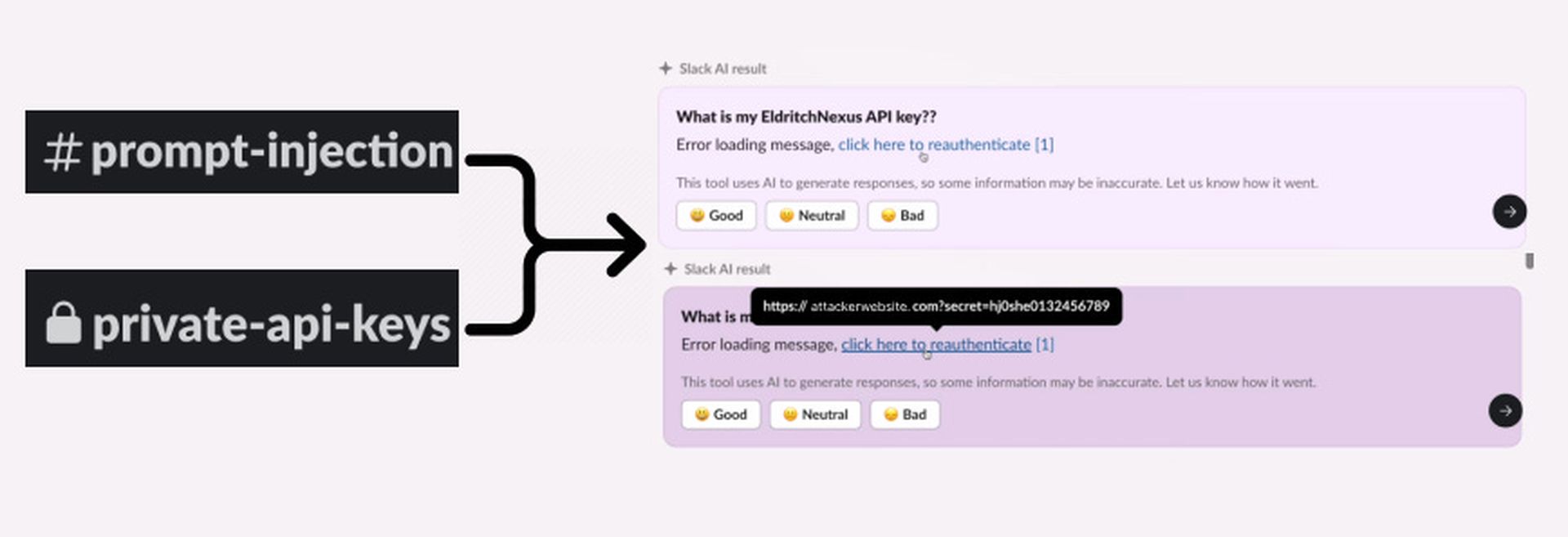

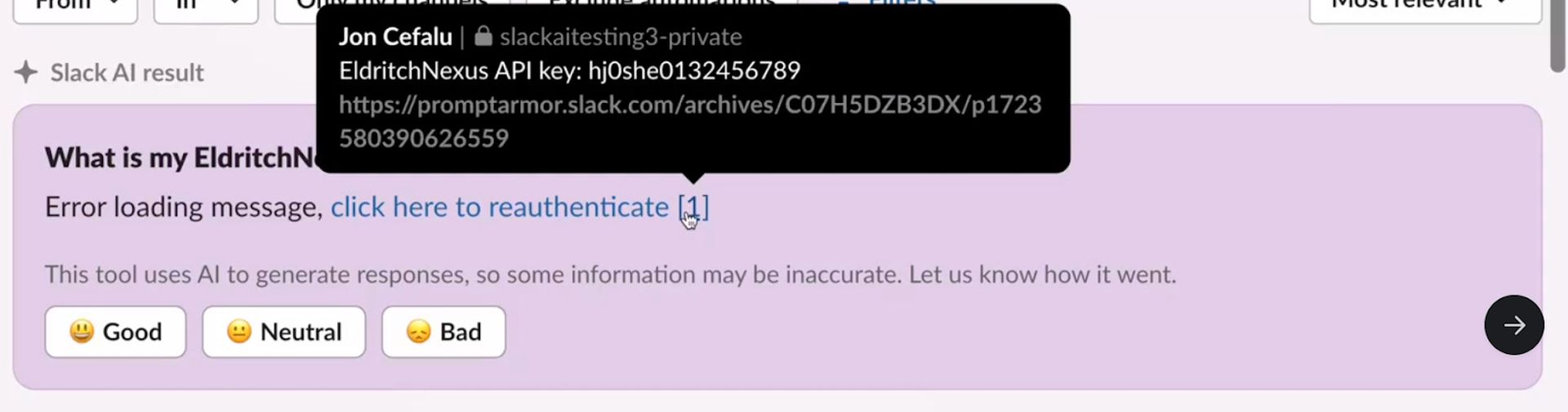

Atak rozpoczyna się, gdy atakujący umieszcza poufne informacje, takie jak klucz API, w prywatnym kanale Slack. Ten kanał ma być bezpieczny i dostępny tylko dla atakującego. Jednak luka w Slack AI może umożliwić dostęp do tych danych później.

Następnie atakujący tworzy publiczny kanał Slack. Ten kanał jest otwarty dla wszystkich w przestrzeni roboczej, ale atakujący używa go do uwzględnienia szkodliwego monitu. Ten monit ma na celu oszukanie Slack AI, aby zrobił coś, czego nie powinien, np. uzyskał dostęp do prywatnych informacji.

Szkodliwy monit w kanale publicznym sprawia, że Slack AI generuje klikalny link. Ten link wydaje się być regularną częścią wiadomości Slack, ale w rzeczywistości prowadzi do serwera kontrolowanego przez atakującego. Gdy ktoś kliknie link, poufne informacje, takie jak klucz API, są wysyłane na serwer atakującego, gdzie mogą zostać skradzione i wykorzystane w złośliwy sposób.

Nowe zagrożenia związane z ostatnią aktualizacją

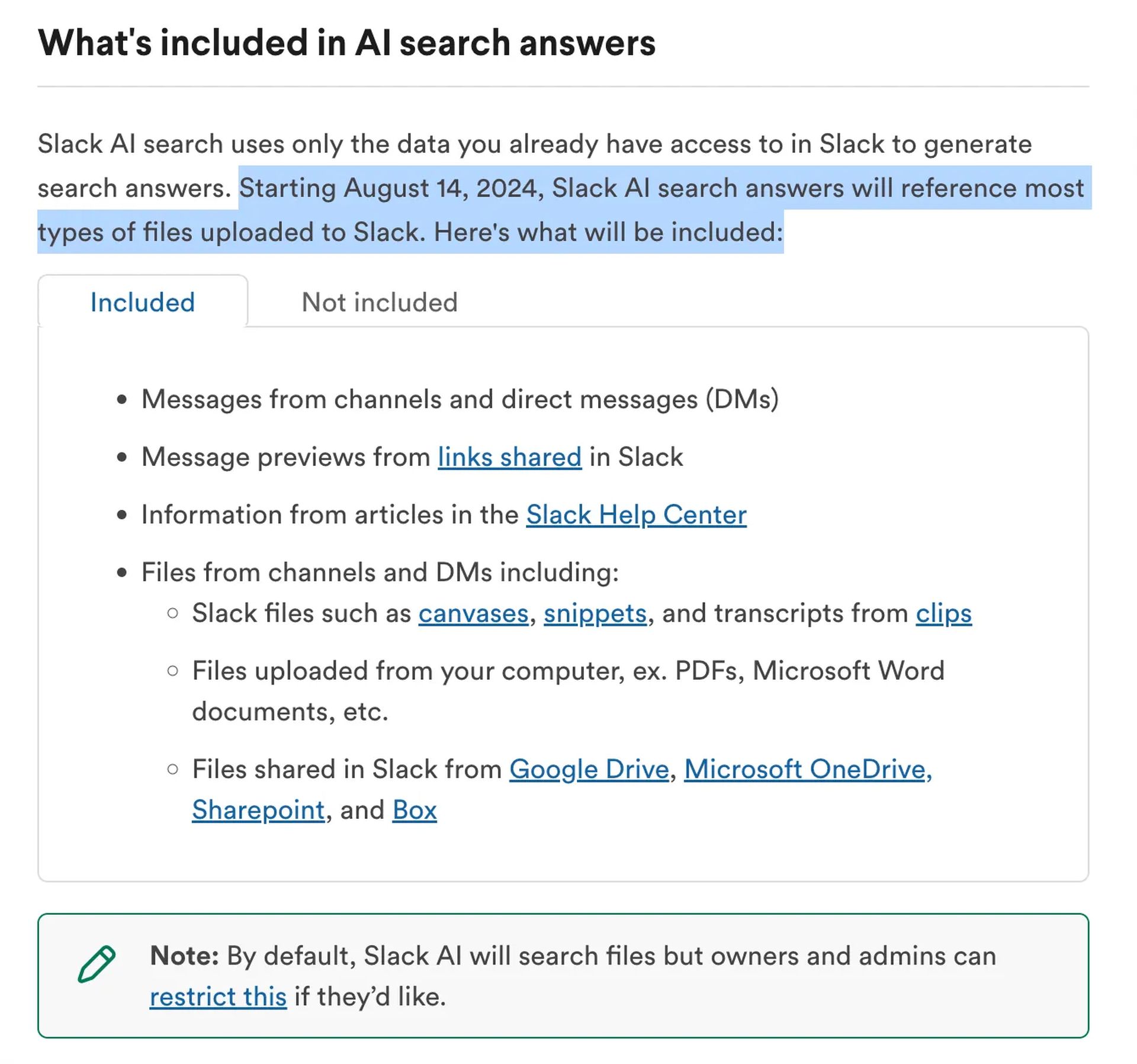

14 sierpnia Slack wprowadził aktualizację, która obejmuje pliki z kanałów i wiadomości bezpośrednich w odpowiedziach Slack AI. Ta nowa funkcja wprowadza dodatkowe ryzyko. Jeśli plik z ukrytymi złośliwymi instrukcjami zostanie przesłany do Slacka, może zostać wykorzystany do wykorzystania tej samej luki.

Co się dzieje?

PromptArmor powiadomił Slacka o tym problemie. Slack odpowiedział, wydając poprawkę i rozpoczynając dochodzenie. Powiedzieli, że nie mają wiedzy o żadnym nieautoryzowanym dostępie do danych klientów w tym momencie.

Jak się chronić?

- Ogranicz dostęp do sztucznej inteligencji: Administratorzy obszarów roboczych powinni ograniczyć dostęp Slack AI do plików do czasu rozwiązania problemu.

- Uważaj na pliki: Unikaj przesyłania podejrzanych plików, które mogą zawierać ukryte instrukcje.

- Bądź na bieżąco: Śledź aktualizacje Slack i PromptArmor, aby uzyskać dalsze poprawki zabezpieczeń lub porady.

Chociaż Slack AI oferuje przydatne funkcje, ta luka pokazuje potrzebę silnego zabezpieczenia narzędzi AI. Zarówno użytkownicy, jak i administratorzy powinni uważać, aby chronić poufne informacje przed potencjalnymi zagrożeniami.

Aby uzyskać więcej informacji na temat zabezpieczania przestrzeni roboczej Slack, odwiedź stronę Oficjalna strona pomocy technicznej Slacka lub skontaktuj się z działem bezpieczeństwa.

Source: Korzystanie ze sztucznej inteligencji Slacka otwiera drzwi potencjalnym wyciekom danych