Microsoft ma rozłożony ekscytujące nowe osiągnięcie w dziedzinie modeli językowych: 1-bitowy LLM. Ten postęp, inspirowany projektami badawczymi takimi jak BitNet, oznacza wyraźną zmianę w sposobie konstruowania i optymalizacji modeli językowych. U podstaw tej innowacji leży uderzająco wydajna metoda przedstawiania parametrów modelu – lub wag –używając zaledwie 1,58 bitów, w przeciwieństwie do tradycyjnego 16-bitowego zapisu zmiennoprzecinkowego (FP16) podejście dominujące we wcześniejszych modelach.

Pierwszy w swoim rodzaju 1-bitowy LLM

Nazwany BitNet LLM b1.58to pionierskie podejście ogranicza potencjalne wartości każdej wagi do zaledwie trzech opcji: -1, 0 lub +1. To radykalne zmniejszenie liczby bitów wymaganych na parametr stanowi podstawę tej przełomowej technologii. Co zaskakujące, pomimo niewielkiego zużycia bitów, BitNet b1.58 sobie z tym radzi dostarczają wskaźników wydajności porównywalnych z tradycyjnymi modelami. Obejmuje to takie obszary, jak zakłopotanie i wydajność zadania końcowego, a wszystko to przy użyciu tego samego rozmiaru i zbiorów danych szkoleniowych.

Co to są 1-bitowe LLM?

Scena generatywnej sztucznej inteligencji ewoluuje z dnia na dzień, a najnowszym przełomem na tej dynamicznej arenie jest pojawienie się 1-bitowych modeli uczenia się języka. Może to zabrzmieć zaskakująco, ale rozwój ten ma potencjał przekształcenia areny sztucznej inteligencji poprzez usunięcie niektórych z najważniejszych przeszkód, przed którymi stoją dziś LLM:mianowicie ich gigantyczny rozmiar.

Zazwyczaj wagi modelu uczenia maszynowego, niezależnie od tego, czy jest to LLM, czy coś tak prostego jak regresja logistyczna, są przechowywane przy użyciu albo 32-bitowe lub 16-bitowe liczby zmiennoprzecinkowe. To standardowe podejście to miecz obosieczny; pozwala to wprawdzie na dużą precyzję obliczeń modelu, ale skutkuje także ogromnymi rozmiarami tych modeli.

To wzdęcie jest właśnie powodem, dla którego wdrażanie mistrzów wagi ciężkiej, takich jak GPT, w systemach lokalnych lub w środowiskach produkcyjnych staje się logistycznym koszmarem. Ich astronomiczna liczba ciężarów, wymuszona precyzją tych zmiennoprzecinkowych punktów, zwiększa ich rozmiar do niemożliwych do opanowania proporcji.

W wyraźnym przeciwieństwie do tradycyjnych modeli, 1-bitowe LLM wykorzystują tylko jeden bit – 0 lub 1 – do reprezentowania parametrów wagi. Ta pozornie drobna poprawka ma poważne konsekwencje: drastycznie zmniejsza ogólny rozmiar modeli, potencjalnie z dużym marginesem.

Takie zmniejszenie rozmiaru otwiera drogę do wdrożenia LLM na znacznie mniejszych urządzeniachdzięki czemu zaawansowane aplikacje AI stają się bardziej zaawansowane dostępne i wykonalne na większej liczbie platform.

Powrót do BitNet LLM b1.58

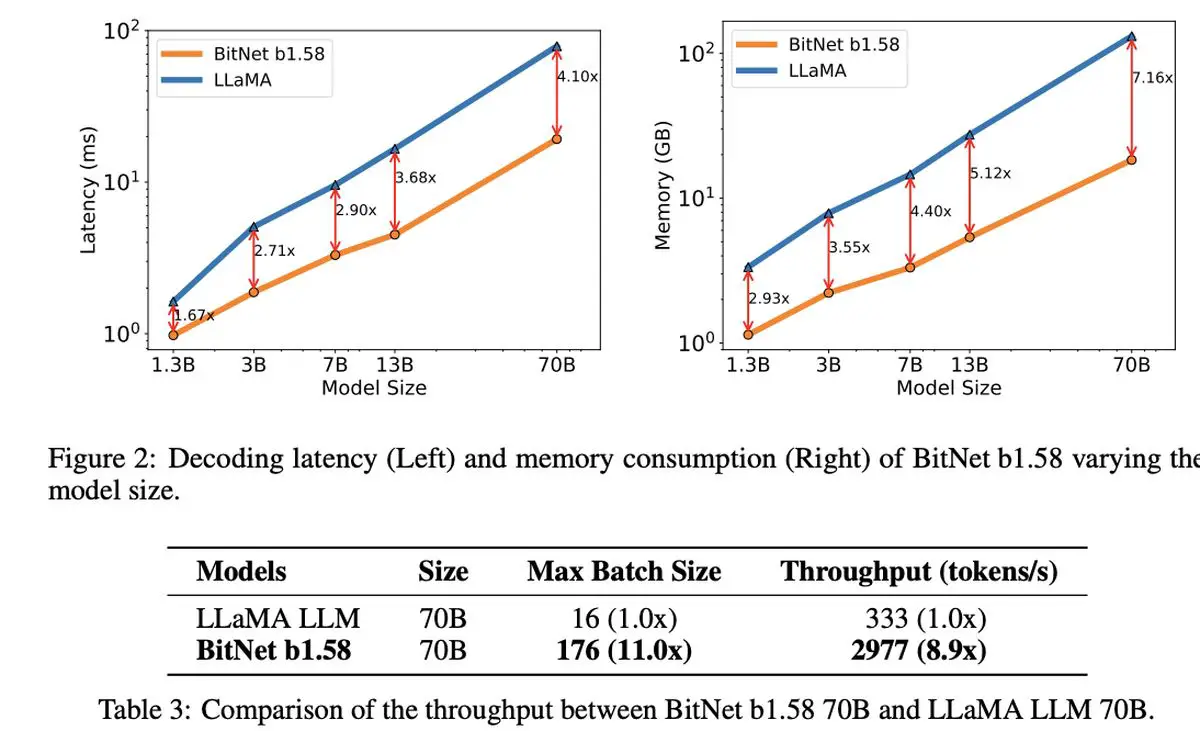

To, co jest naprawdę niezwykłe w 1,58-bitowym LLM, to jego Opłacalność. Model wyróżnia się mniejszymi opóźnieniami, mniejszym zużyciem pamięci, zwiększoną przepustowością i zmniejszonym zużyciem energii, stanowiąc zrównoważoną opcję w wymagającym obliczeniowo świecie sztucznej inteligencji.

1-bitowy LLM firmy Microsoft wyróżnia się nie tylko wydajnością. Reprezentuje świeże spojrzenie na skalowanie i szkolenie modeli językowych, równoważąc najwyższą wydajność z opłacalnością ekonomiczną. Wskazuje to na początek nowych paradygmatów obliczeniowych i możliwość stworzenia specjalistycznego sprzętu dostosowanego do obsługi tych cieńszych, bardziej wydajnych modeli.

Otwiera się również dyskusja wokół BitNet LLM b1.58 intrygujące możliwości skuteczniejszego zarządzania długimi sekwencjami w LLMsugerując potencjalne obszary dalszych badań w technikach kompresji bezstratnej, aby jeszcze bardziej zwiększyć wydajność.

W cieniu tej godnej uwagi innowacji Microsoft również zrobił furorę dzięki najnowszemu modelowi małego języka, Phi-2. Ten potężny moduł liczący 2,7 miliarda parametrów wykazał się wyjątkowymi zdolnościami w zakresie rozumienia i rozumowania, co stanowi kolejny dowód na ciągłe zaangażowanie firmy Microsoft w przesuwanie granic technologii sztucznej inteligencji. Wprowadzenie 1-bitowego LLM wraz z sukcesem Phi-2 uwypukliłoby ekscytującą erę innowacji i wydajności w rozwoju modelu językowego.

Autor wyróżnionego obrazu: Drew Beamer/Unsplash

Source: Microsoft wprowadza 1-bitowy LLM