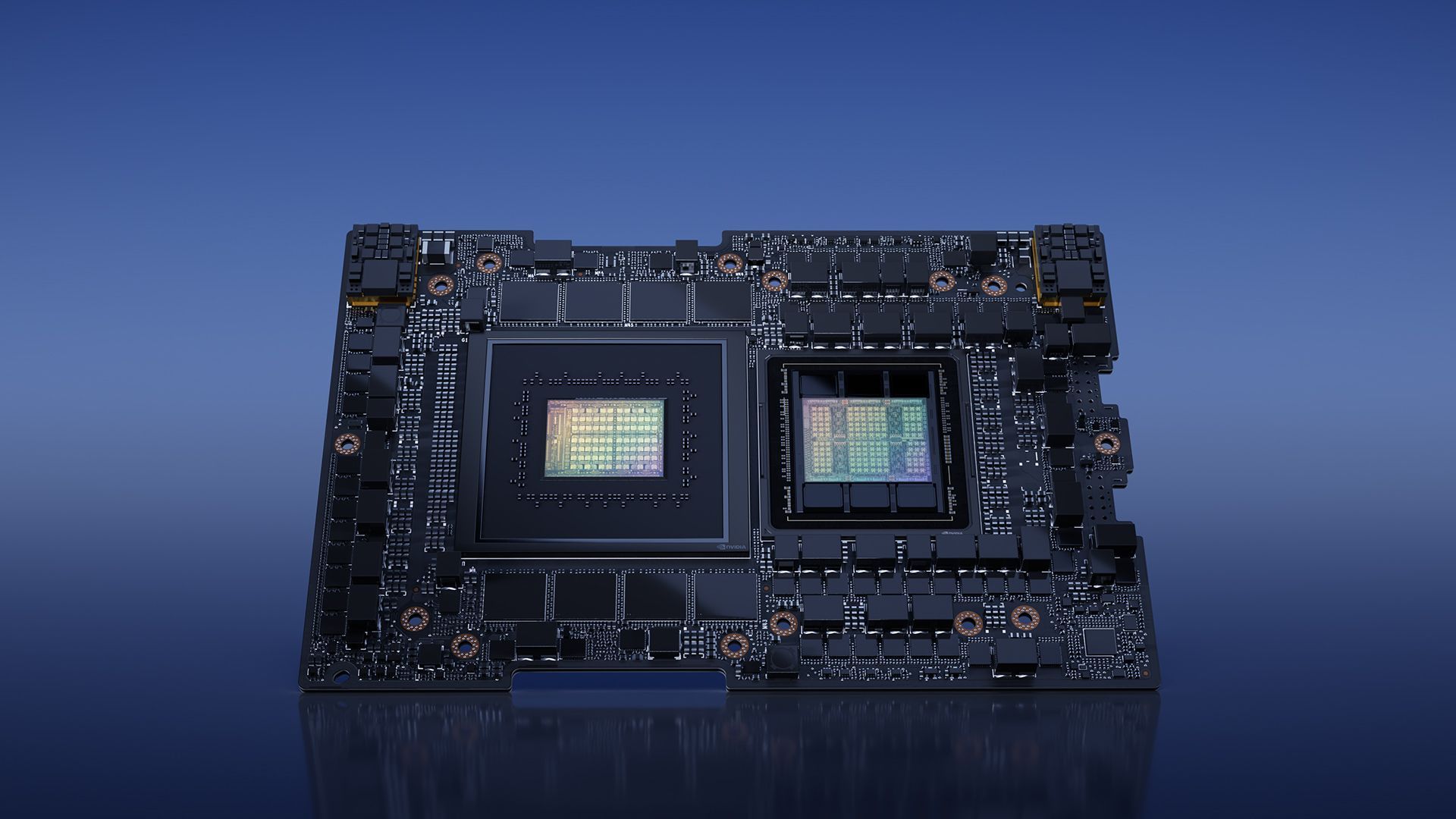

Nvidia rewolucjonizuje świat obliczeń opartych na sztucznej inteligencji niedawna premiera NVIDIA H200. Ta najnowocześniejsza platforma zbudowana na bazie Skoczek NVIDIA architekturę, może poszczycić się wydajnym procesorem graficznym NVIDIA H200 Tensor Core, wyposażonym w zaawansowana pamięć przeznaczony do walki znaczne obciążenie danymi do obciążeń związanych z generatywną sztuczną inteligencją i obliczeniami o wysokiej wydajności (HPC).

architekturę, może poszczycić się wydajnym procesorem graficznym NVIDIA H200 Tensor Core, wyposażonym w zaawansowana pamięć przeznaczony do walki znaczne obciążenie danymi do obciążeń związanych z generatywną sztuczną inteligencją i obliczeniami o wysokiej wydajności (HPC).

W tym artykule przyjrzymy się niedawnej premierze i podamy jak najwięcej szczegółów na temat nowej karty NVIDIA H200.

Moc NVIDIA H200

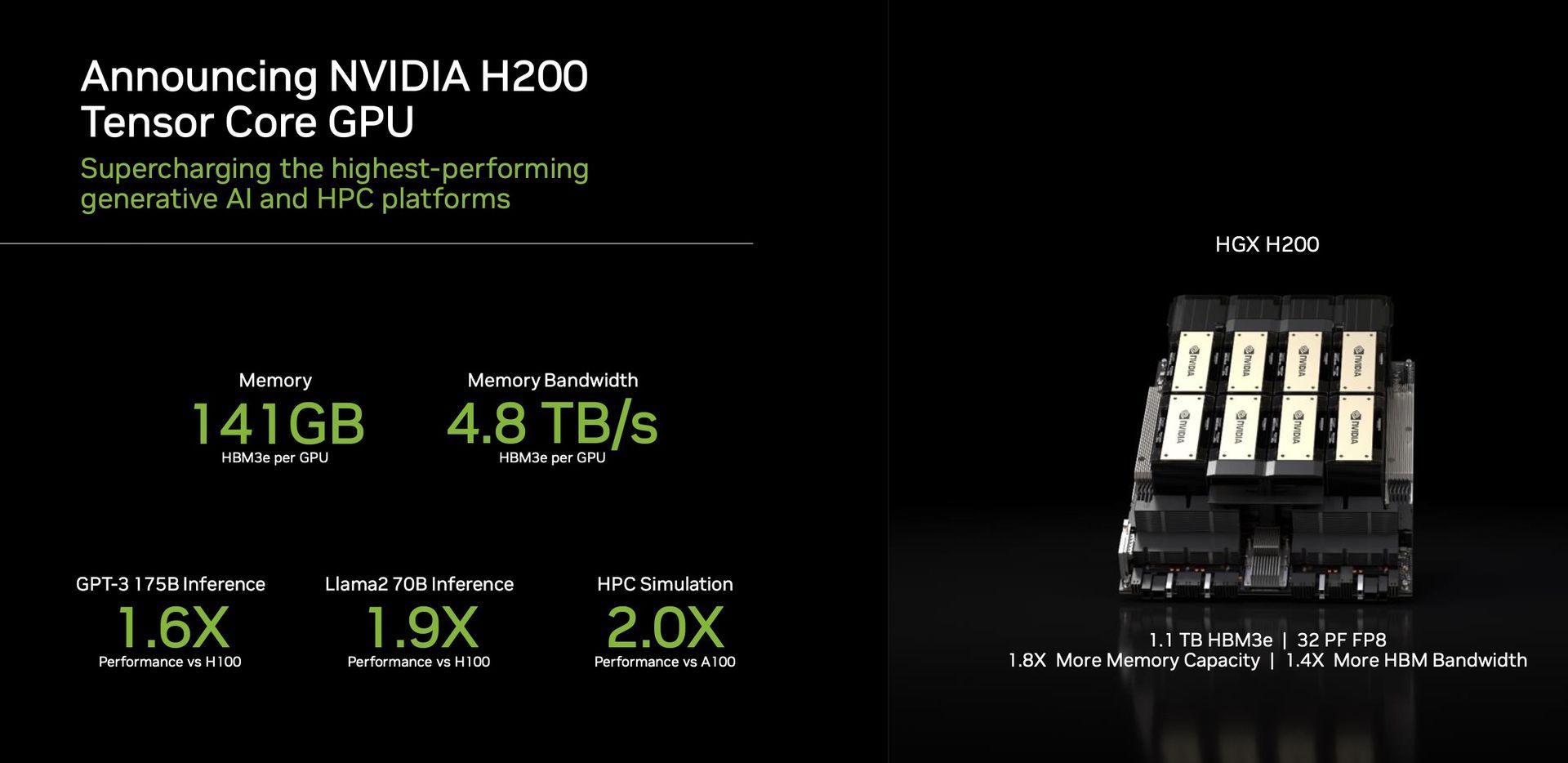

Cechą wyróżniającą H200 jest wykorzystanie HBM3e, pierwszy procesor graficzny oferujący szybszą i większą pamięć. Postęp ten napędza przyspieszenie generatywnej sztucznej inteligencji i dużych modeli językowych, jednocześnie przesuwając granice obliczenia naukowe dla obciążeń HPC. Dzięki HBM3e, H200 zapewnia imponujące 141 GB pamięci w zdumiewający sposób 4,8 terabajta na sekundę. Oznacza to prawie dwukrotnie większą pojemność i 2,4 razy większa przepustowość w porównaniu do swojego poprzednika, NVIDIA A100.

Wydajność i zastosowania

H200, zasilany przez NVIDIA NVLink i NVSwitch

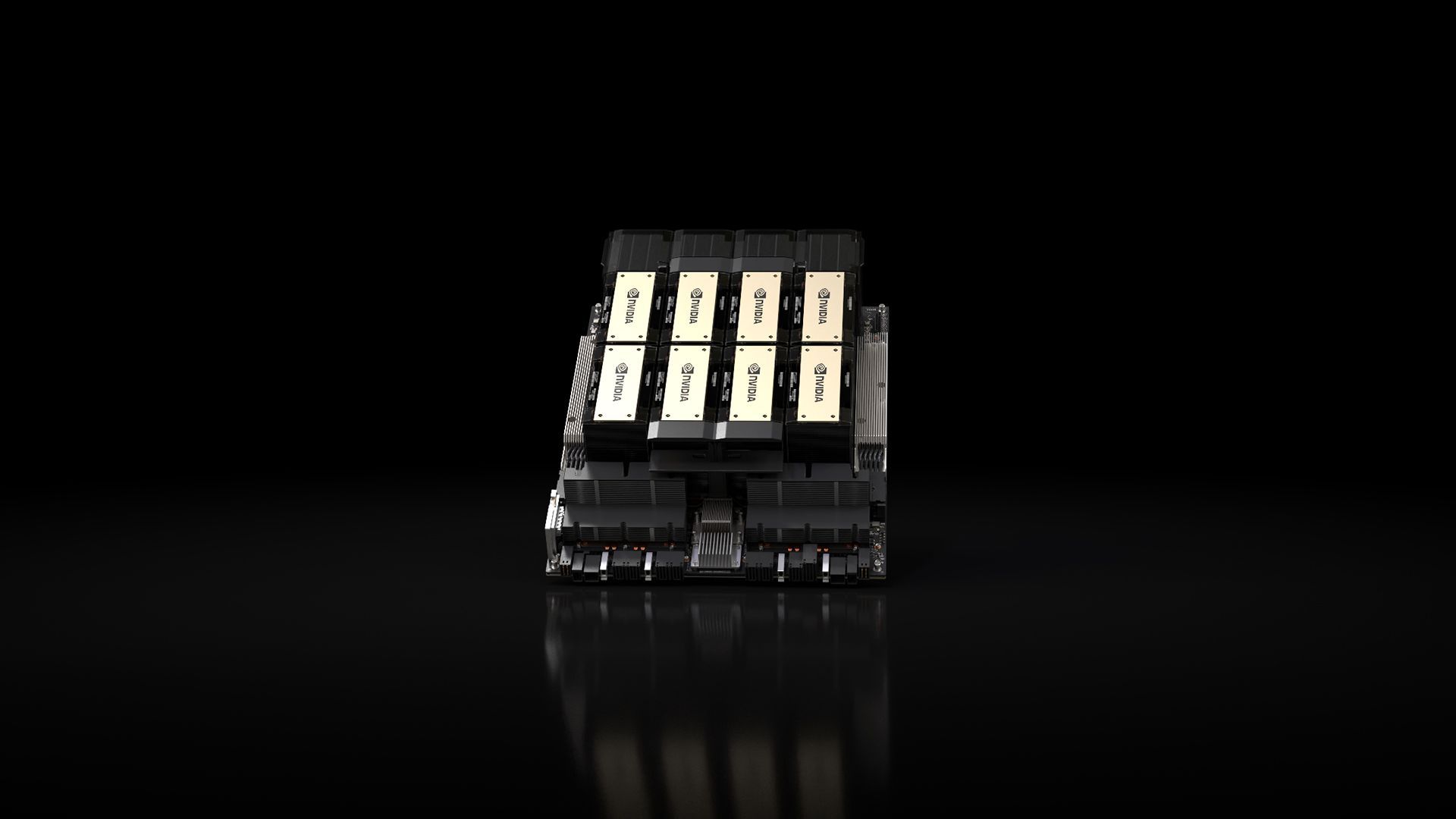

i NVSwitch szybkie połączenia międzysieciowe, obiecuje niezrównana wydajność w różnych obciążeniach aplikacji. Obejmuje to jego umiejętności w szkoleniu LLM (Large Language Model) i wnioskowaniu dla modeli przewyższających kolosalną 175 miliardów parametrów. Ośmiokierunkowy model HGX H200 wyróżnia się ponadprzeciętną wydajnością Głębokość 32 petaflopów 8PR nauka obliczeń I łączna pamięć o dużej przepustowości 1,1 TB, zapewniając najwyższą wydajność w generatywnych zastosowaniach AI i HPC.

szybkie połączenia międzysieciowe, obiecuje niezrównana wydajność w różnych obciążeniach aplikacji. Obejmuje to jego umiejętności w szkoleniu LLM (Large Language Model) i wnioskowaniu dla modeli przewyższających kolosalną 175 miliardów parametrów. Ośmiokierunkowy model HGX H200 wyróżnia się ponadprzeciętną wydajnością Głębokość 32 petaflopów 8PR nauka obliczeń I łączna pamięć o dużej przepustowości 1,1 TB, zapewniając najwyższą wydajność w generatywnych zastosowaniach AI i HPC.

Procesory graficzne Nvidii stały się kluczowy w dziedzinie generatywnych modeli sztucznej inteligencji, odgrywając kluczową rolę w ich rozwoju i wdrażaniu. Zaprojektowane do obsługi ogromnych obliczeń równoległych wymaganych do szkolenia i uruchamiania tych modeli, procesory graficzne Nvidii doskonale radzą sobie z zadaniami takimi jak generowanie obrazu I język naturalny przetwarzanie. Architektura przetwarzania równoległego umożliwia wydajność tych procesorów graficznych wiele obliczeń jednocześnie, co skutkuje znacznym przyspieszeniem procesów modeli generatywnych AI.

H200 jest świadectwem zaangażowania Nvidii w ciągłe skoki w zakresie innowacji i wydajności. Bazując na sukcesie architektury Hopper, wprowadzono ciągłe udoskonalenia oprogramowania, w tym niedawne wydanie bibliotek typu open source, takich jak NVIDIA TensorRT -LLM, w dalszym ciągu podnosić wydajność platformy. Wprowadzenie NVIDIA H200 obiecuje dalszy skok, przy oczekiwaniach na poziomie niemal podwojenie szybkości wnioskowania w modelach takich jak Llama 2, LLM o 70 miliardach parametrów, w porównaniu do swojego poprzednika, H100.

-LLM, w dalszym ciągu podnosić wydajność platformy. Wprowadzenie NVIDIA H200 obiecuje dalszy skok, przy oczekiwaniach na poziomie niemal podwojenie szybkości wnioskowania w modelach takich jak Llama 2, LLM o 70 miliardach parametrów, w porównaniu do swojego poprzednika, H100.

Wszechstronność i dostępność

Nvidia zapewnia wszechstronność z H200, oferując go w różnych obudowach, takich jak płyty serwerowe NVIDIA HGX H200 w konfiguracjach cztero- i ośmioprocesorowych. Konfiguracje te są kompatybilne zarówno ze sprzętem, jak i oprogramowaniem systemów HGX H100. Dodatkowo, NVIDIA H200 jest dostępna w zbiornik NVIDIA GH200 Grace Superchip z HBM3e, obsługujący różne konfiguracje centrów danych, w tym środowiska lokalne, chmurowe, chmury hybrydowe i brzegowe. Globalny ekosystem producentów serwerów partnerskich może bezproblemowo aktualizować istniejące systemy z H200, zapewniając powszechną dostępność.

Superchip z HBM3e, obsługujący różne konfiguracje centrów danych, w tym środowiska lokalne, chmurowe, chmury hybrydowe i brzegowe. Globalny ekosystem producentów serwerów partnerskich może bezproblemowo aktualizować istniejące systemy z H200, zapewniając powszechną dostępność.

Entuzjaści i eksperci branżowi z niecierpliwością czekają na wprowadzenie na rynek systemów HGX H200, które mają trafić na rynek w drugi kwartał 2024 r. Wybitni światowi gracze, tacy jak Usługi internetowe Amazona, Chmura Google, Microsoft Azure, I Infrastruktura chmurowa Oracle są pośród pierwsza fala dostawców usług w chmurze gotowi do wdrożenia instancji opartych na H200 w przyszłym roku.

architektura (Kredyt obrazu)

architektura (Kredyt obrazu)Podsumowując, NVIDIA H200, ze swoimi przełomowymi funkcjami i możliwościami wydajnościowymi, jest nastawiona na na nowo zdefiniować krajobraz przetwarzania AI. H200, który będzie dostępny w drugim kwartale 2024 r., będzie gotowy zwiększyć możliwości programistów i przedsiębiorstw na całym świecie, przyspieszenie rozwoju i wdrażania aplikacji AI od mowy do wnioskowania hiperskalowego.

Tymczasem, jeśli interesuje Cię wiodąca firma technologiczna, zapoznaj się również z naszym artykułem o tym, jak Nvidia i AMD pracują nad „chipem opartym na ramieniu”.

Autor wyróżnionego obrazu: NVIDIA

Source: NVIDIA H200 została wprowadzona z dużym niecierpliwością w sferze sztucznej inteligencji