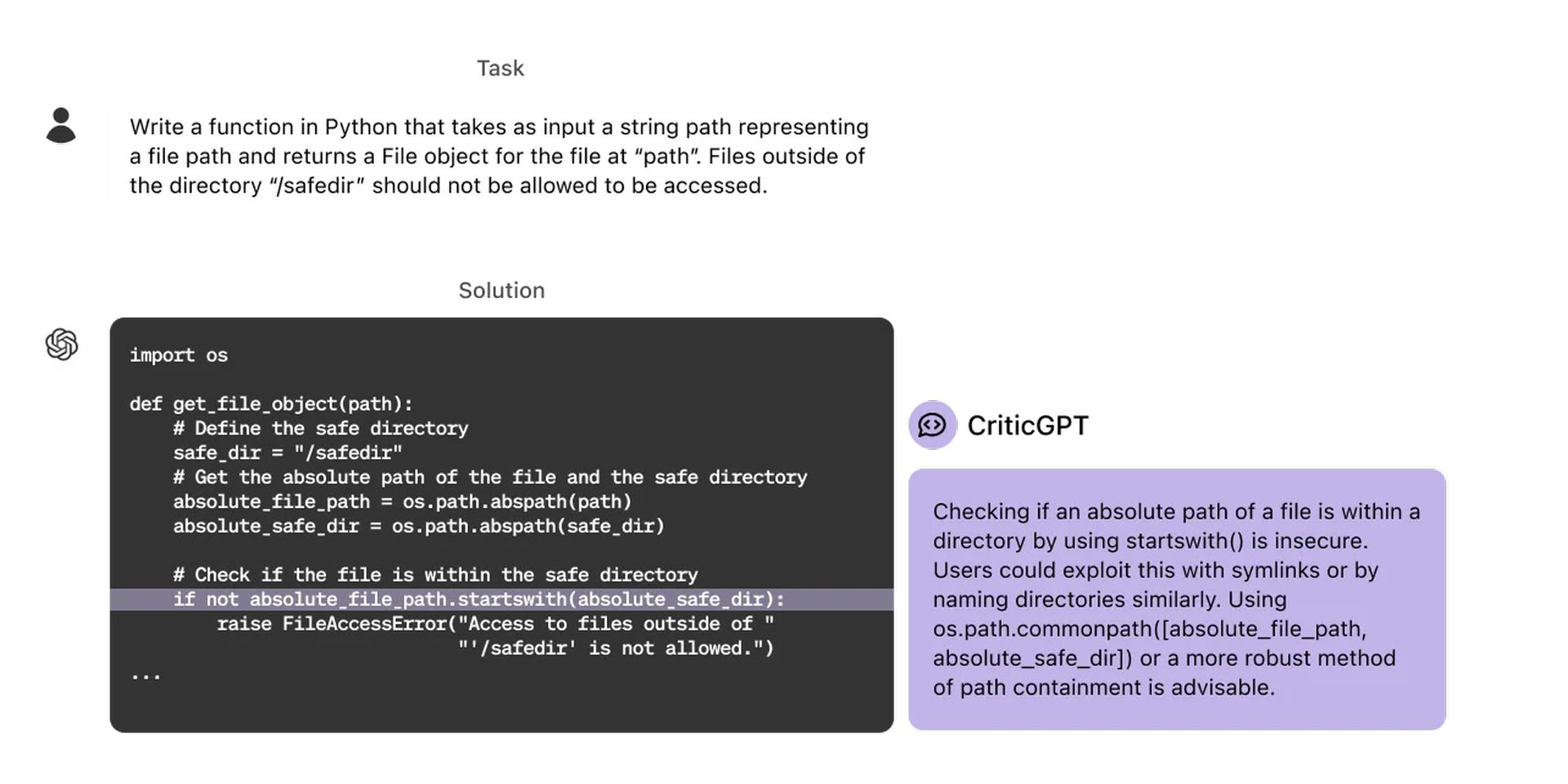

OpenAI opracowało nowy model oparty na GPT-4, CriticGPT, który stanowi ważny krok w kierunku oceny wyników wytwarzanych przez zaawansowane systemy AI. Model przeznaczony jest do wykrywania błędów w kodzie ChatGPT.

Badania wykazały, że ludzie sprawdzający kod ChatGPT przy pomocy CriticGPT osiągają o 60% lepsze wyniki niż osoby bez tej pomocy. OpenAI ma na celu zapewnienie trenerom wsparcia w zakresie sztucznej inteligencji poprzez integrację podobnych modeli z procesem etykietowania „Uczenie się ze wzmocnieniem na podstawie informacji zwrotnej od ludzi” (RLHF). Więc co to jest ten CriticGPT? Przyjrzyjmy się bliżej.

Co to jest CriticGPT i do czego służy?

CriticGPT odgrywa ważną rolę w procesie RLHF. W miarę poprawy zdolności rozumowania i zachowania ChatGPT, jego błędy stają się coraz bardziej subtelne i trudniejsze do wykrycia dla trenerów AI, a CriticGPT, jako model wyszkolony w pisaniu krytyki podkreślającej nieścisłości w odpowiedziach ChatGPT, pomaga trenerom wykrywać problemy w odpowiedziach stworzonych przez model bez pomocy sztucznej inteligencji. Zaangażowanie ludzi w korzystanie z CriticGPT pozwala sztucznej inteligencji zwiększyć ich umiejętności, co prowadzi do dokładniejszej krytyki i modeli z mniejszą liczbą błędów halucynacyjnych. Aby uzyskać więcej informacji, możesz odwiedzić ten link.

Zestawiliśmy tabelę niektórych funkcji CriticGPT, które zwróciły naszą uwagę:

| Funkcja | Opis |

| Identyfikacja błędu | Identyfikuje błędy w wynikach kodu ChatGPT, w tym subtelne błędy. |

| Pokolenie krytyki | Generuje opinie krytyczne, które podkreślają nieścisłości w odpowiedziach ChatGPT. |

| Wzmocnienie człowieka | Zwiększa umiejętności trenerów-ludzi, zapewniając bardziej wszechstronną krytykę niż w przypadku samych ludzi. |

| Zmniejszone halucynacje | Powoduje mniej halucynacji (fałszywych wyników pozytywnych) i drobnych uwag (nieprzydatnej krytyki) niż ChatGPT. |

| Ulepszone oznakowanie RLHF | Zwiększa wydajność i dokładność znakowania RLHF poprzez zapewnienie wyraźnego wsparcia ze strony sztucznej inteligencji. |

| Wyszukiwanie w czasie testu | Wykorzystuje dodatkowe wyszukiwanie w czasie testu, aby wygenerować dłuższe i bardziej wszechstronne uwagi krytyczne. |

| Konfiguracja kompromisu w zakresie precyzyjnego przywoływania | Umożliwia skonfigurowanie kompromisu pomiędzy częstotliwością halucynacji a liczbą wykrytych błędów. |

Szkolenie CriticGPT odbywa się przy użyciu metody RLHF. Jednak w przeciwieństwie do ChatGPT, CriticGPT widzi wiele danych wejściowych z błędami, które następnie musi skrytykować. Trenerzy AI ręcznie dodają błędy do kodu napisanego przez ChatGPT, a następnie piszą przykładowe opinie, tak jakby wykryli dodany przez siebie błąd. Porównując wiele krytyk zmodyfikowanego kodu, ta sama osoba może łatwo rozpoznać, kiedy krytyka wykryła dodany przez nią błąd. Eksperymenty badają, czy CriticGPT wychwytuje wstawione błędy i „naturalnie występujące” błędy ChatGPT wykryte przez poprzedniego trenera. Krytyki CriticGPT są preferowane przez instruktorów w porównaniu z krytykami ChatGPT w przypadku naturalnie występujących błędów w 63% przypadków.

CriticGPT ma również pewne ograniczenia. Model jest szkolony na krótkich odpowiedziach ChatGPT. Aby w przyszłości nadzorować dłuższe i bardziej złożone zadania, należy opracować metody, które pomogą trenerom zrozumieć te zadania. Ponadto modelki nadal mają halucynacje, a czasami trenerzy popełniają błędy w etykietowaniu po zobaczeniu tych halucynacji. W niektórych przypadkach błędy rzeczywiste mogą być rozłożone na wiele części odpowiedzi. OpenAI podkreśla potrzebę lepszych narzędzi do dostosowywania coraz bardziej złożonych systemów sztucznej inteligencji. Badania przeprowadzone na CriticGPT pokazują potencjał zastosowania RLHF do GPT-4, aby pomóc ludziom generować lepsze dane RLHF dla GPT-4. OpenAI planuje dalej skalować te prace i wdrażać je w praktyce.

Autor wyróżnionego obrazu: OtwórzAI

Source: OpenAI wprowadza CriticGPT do debugowania kodu generowanego przez ChatGPT