Gemma 2 właśnie wkroczyła na scenę 2D AI i wywołuje spore poruszenie. Ten maleńki model dowodzi, że dobre rzeczy przychodzą w małych opakowaniach i wywołuje prawdziwą dyskusję w świecie technologii.

Najnowszy wynalazek Google, Gemma 2 2B, to kompaktowy model językowy z zaledwie 2,6 miliarda parametrów. Pomimo niewielkich rozmiarów, ta potęga AI dorównuje swoim większym braciom. Gemma 2 2B nie tylko mówi, ale też robi, dorównując, a nawet przewyższając modele dziesięć razy większe.

Błyszczący występ Gemmy 2 2B

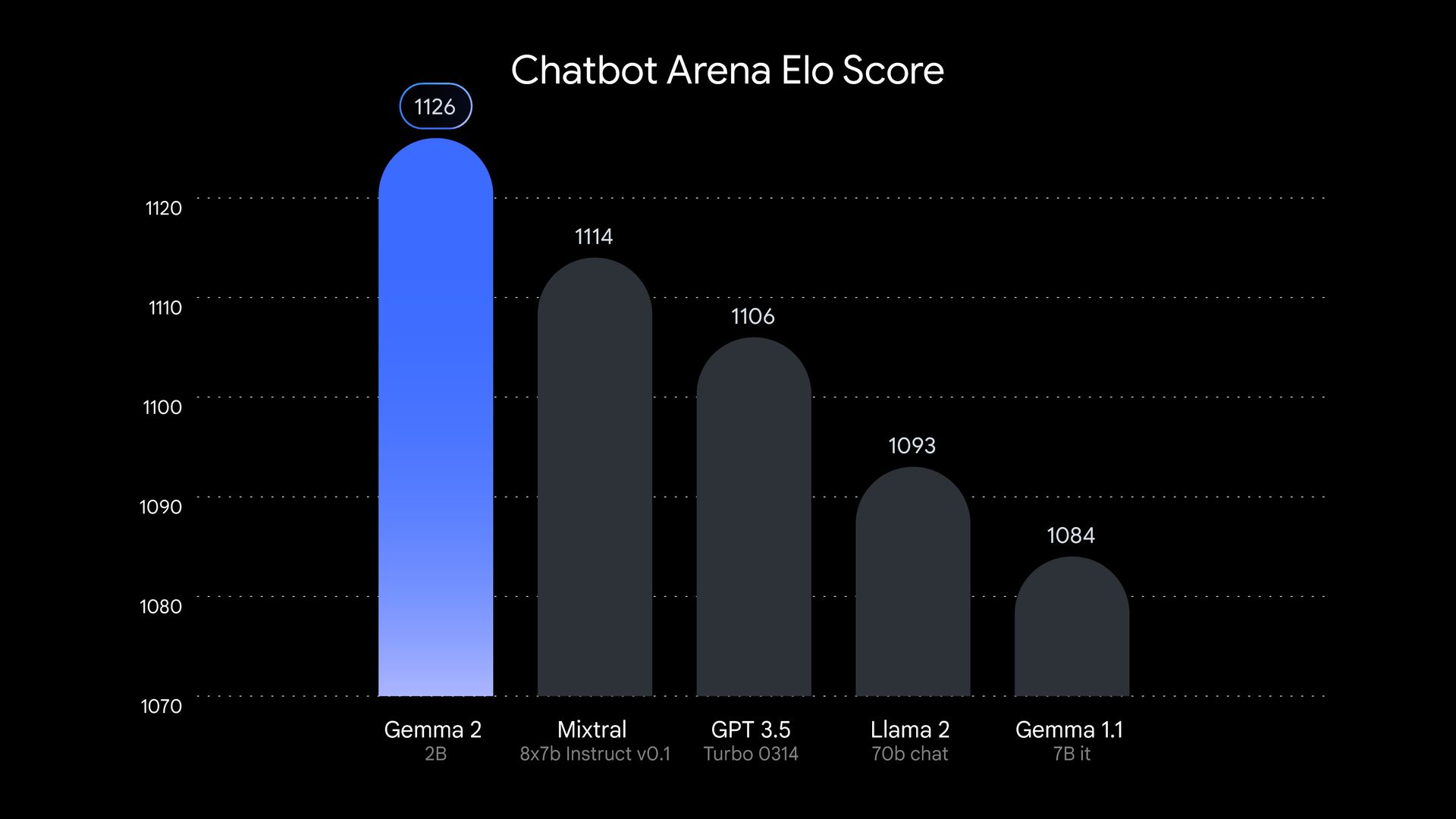

Powiedzmy sobie jasno, że Gemma 2 2B nie jest kolejną wielką siłą w tłumie wielkiej sztucznej inteligencji. Ten model został wystawiony na próbę i okazał się świetny. W testach przeprowadzonych przez LMSYSniezależna grupa badawcza zajmująca się sztuczną inteligencją, Gemma 2 2B, uzyskała imponujący wynik 1130 punktów na arenie ocen. Tak, ten mały klejnot przewyższył niektóre duże nazwy, takie jak GPT-3.5-Turbo-0613 i Mixtral-8x7B.

Ale Gemma 2 2B na tym się nie kończy. Pokazuje, że jest inteligentna także w innych obszarach. W MMLU benchmark, który testuje zdolność modelu do rozumienia i rozumowania na różne tematy, Gemma 2 2B uzyskała 56,1 punktów. Jeśli chodzi o kodowanie, uzyskała 36,6 punktów w MBPP test. Te liczby oznaczają skok kwantowy w stosunku do poprzednika.

Jak więc Google stworzyło ten mały zastanawiasz się? Gemma 2 2B została wytrenowana na ogromnym zestawie danych 2 bilionów tokenów przy użyciu zaawansowanego sprzętu TPU v5e firmy Google. Ten proces trenowania pozwolił modelowi spakować wiele informacji do swojej kompaktowej ramy. Gemma 2 2B jest również wielojęzyczna, co rozszerza jej potencjalne przypadki użycia na cały świat. Dzięki temu jest wszechstronnym narzędziem dla programistów i badaczy pracujących nad projektami międzynarodowymi.

Sukces Gemma 2 2B podważa ideę, że w AI większe zawsze znaczy lepsze. Jego imponujące wyniki pokazują, że przy odpowiednich technikach szkoleniowych, wydajnych architekturach i wysokiej jakości danych mniejsze modele mogą wznieść się znacznie ponad swoją klasę wagową. Ten rozwój może zmienić nacisk w badaniach nad AI z tworzenia większych modeli na ulepszanie mniejszych, bardziej wydajnych modeli. Jest to zmiana, która może mieć daleko idące implikacje dla tej dziedziny i potencjalnie uczynić AI bardziej dostępną i przyjazną dla środowiska.

Polerowanie przyszłości AI

Gemma 2 2D reprezentuje rosnący trend w AI w kierunku bardziej wydajnych modeli. Wraz ze wzrostem obaw o wpływ na środowisko i dostępność dużych modeli językowych, firmy technologiczne szukają sposobów na tworzenie mniejszych systemów, które mogą działać na codziennym sprzęcie.

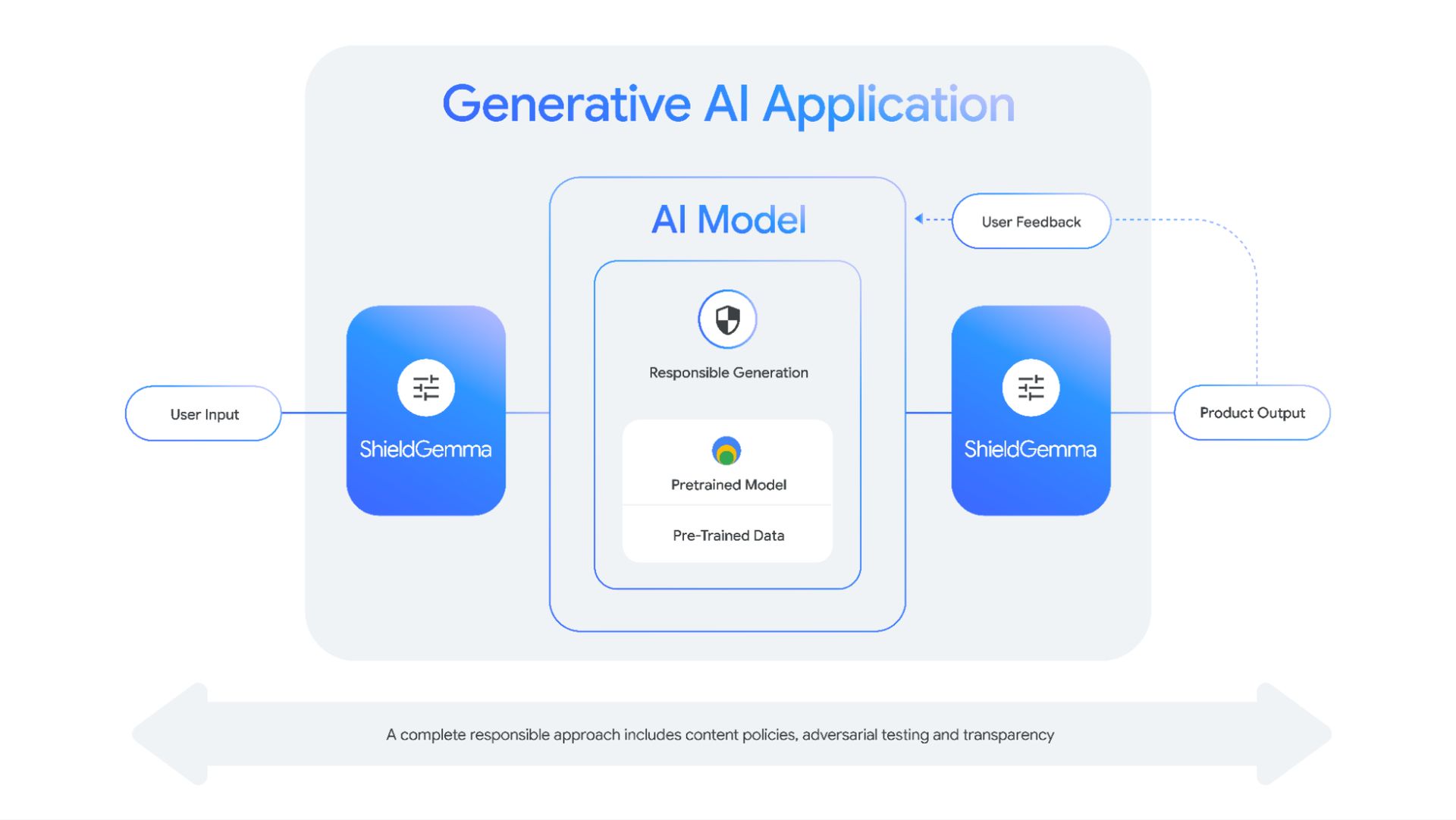

Sukces Gemma 2 2D podkreśla również znaczenie technik kompresji i destylacji modeli. Dzięki skutecznemu kondensowaniu wiedzy z większych modeli do mniejszych naukowcy mogą tworzyć bardziej dostępne narzędzia AI bez poświęcania wydajności.

To podejście nie tylko zmniejsza moc obliczeniową wymaganą do uruchomienia tych modeli, ale także rozwiązuje problemy związane z wpływem szkolenia i uruchamiania dużych systemów AI na środowisko. Jest to sytuacja korzystna dla obu stron, która może ukształtować przyszłość rozwoju AI.

Gemma 2 2B dowodzi, że jeśli chodzi o AI, nie rozmiar ma znaczenie, ale sposób, w jaki go używasz. Ten mały, ale potężny model kwestionuje nasze założenia dotyczące AI i toruje drogę dla nowej generacji wydajnych, potężnych i dostępnych systemów AI. Jest jasne, że ten mały klejnot zabłyśnie w świecie AI.

Źródło wyróżnionego obrazu: Google