Meta Llama 3.1 405B została oficjalnie zaprezentowana, zyskując sobie sławę jeszcze przed wprowadzeniem na rynek jej możliwości AI. Opracowany przez Meta, ten najnowocześniejszy model oferuje bezprecedensową elastyczność, kontrolę i wydajność, aby konkurować z najlepszymi modelami AI o zamkniętym kodzie źródłowym.

Wczoraj niektórzy użytkownicy mieli okazję przekonać się o jego potencjale, a dziś mamy oficjalne testy porównawcze, które podkreślają jego imponujące możliwości. Możesz również przeczytać więcej o wczorajszych rewelacjach tutaj.

Czym jest Meta Llama 3.1 405B?

Dzisiaj dowiemy się wszystkiego, co warto wiedzieć o Meta Llama 3.1 405B. Llama 3.1 405B to sztuczna inteligencja typu open source, która doskonale radzi sobie z różnymi zadaniami, takimi jak wiedza ogólna, nawigacja, matematyka, korzystanie z narzędzi i tłumaczenia wielojęzyczne, podczas gdy wersje średniego poziomu 70B i minimalnego poziomu 8B również doskonale radzą sobie w swoich klasach. Dzięki długości kontekstu 128K i obsłudze ośmiu języków ten model jest przeznaczony do obsługi złożonych i różnorodnych aplikacji.

Wyszkolony na ponad 15 bilionach tokenów przy użyciu ponad 16 tysięcy procesorów graficznych H100, Llama 3.1 405B wyróżnia się jako jeden z najpotężniejszych i najzdolniejszych dostępnych modeli AI. Włożono w tę AI dużo energii. Teraz możemy zacząć wchodzić w szczegóły techniczne.

Główne cechy Meta Llama 3.1 405B

Meta Lama 3.1 405B oferuje kilka zaawansowanych funkcji:

- Rozszerzona długość kontekstu:Obsługuje długość kontekstu do 128 KB, co jest idealne do streszczania dłuższych tekstów i złożonych konwersacji.

- Możliwości wielojęzyczne:Obsługuje wiele języków, co czyni go wszechstronnym w zastosowaniach globalnych.

- Zaawansowane wykorzystanie narzędzi:Możliwość integracji z różnymi narzędziami w celu zwiększenia funkcjonalności.

- Generowanie danych syntetycznych:Ułatwia tworzenie danych syntetycznych w celu udoskonalania i trenowania mniejszych modeli.

- Destylacja modelowa:Umożliwia destylację dużych modeli do mniejszych, bardziej wydajnych wersji.

Meta nawiązała współpracę z ponad 25 firmami, aby Meta Lama 3.1 405B łatwiejszy w użyciu. To wsparcie ekosystemu sprawia, że praca z tym potężnym modelem jest bardziej wykonalna dla deweloperów i badaczy, nawet bez dostępu do ogromnych zasobów obliczeniowych.

Jak używać Meta Llama 3.1 405B

Aby rozpocząć korzystanie z Meta Llama 3.1 405B, wykonaj następujące kroki:

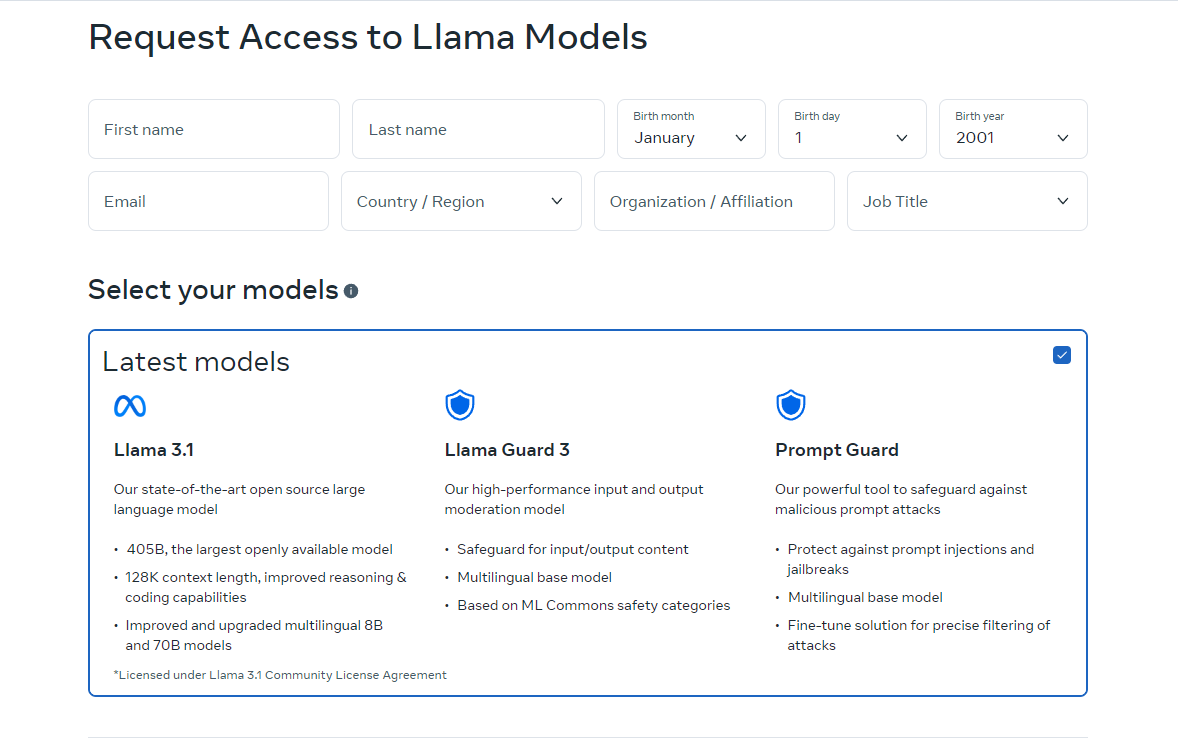

- Uzyskaj dostęp do modelu: Odwiedzać lama.meta.com Lub Przytulanie twarzy Do pobierać model. Te platformy zapewniają niezbędne pliki i dokumentację, aby rozpocząć.

- Skonfiguruj swoje środowisko: Upewnij się, że masz odpowiednie środowisko do uruchomienia modelu. Obejmuje to posiadanie wymaganego sprzętu, takiego jak GPU, i zależności oprogramowania, takich jak Python i PyTorch.

- Załaduj model: Użyj dostarczonych fragmentów kodu i wytycznych, aby załadować model do swojej aplikacji. Meta zapewnia szczegółowe instrukcje, które pomogą Ci zintegrować Llama 3.1 405B z Twoimi projektami.

- Uruchom wnioskowanie: Zacznij używać modelu do wnioskowania w czasie rzeczywistym lub wsadowego. Możesz zadawać pytania modelowi, generować tekst lub wykonywać tłumaczenia, korzystając z jego potężnych możliwości.

- Dopasuj do konkretnych zadań: W razie potrzeby możesz dostroić model do konkretnych zastosowań, korzystając z technik dostrajania nadzorowanego. Meta oferuje zasoby i przykłady, które poprowadzą Cię przez ten proces.

Wersja online Llama jest obecnie dostępna tylko w niektórych krajach. Możesz jednak używać jej lokalnie, pobierając kody open-source. Instrukcje pobierania są dostępne na stronach, do których Cię kierujemy. Możesz również używać Meta Llama 3.1 405B za pośrednictwem Grog.

Jak używać Meta Llama 3.1 405B na Groq

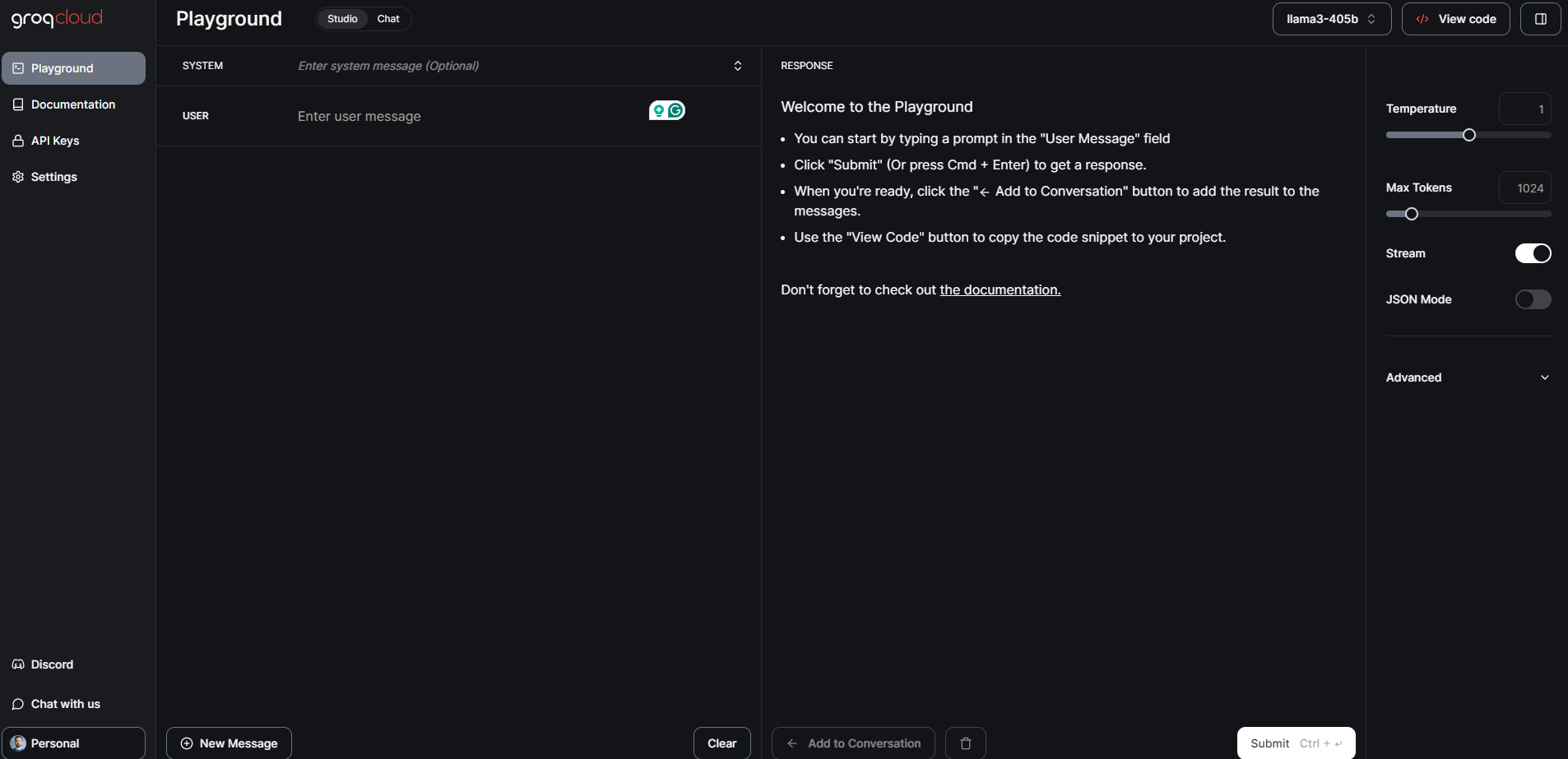

Meta Llama 3.1 405B, największy i najbardziej wydajny model z otwartym fundamentem do tej pory, jest teraz dostępny na Groq. Ten przewodnik przeprowadzi Cię przez rozpoczęcie korzystania z Meta Llama 3.1 405B na Groq.

Krok 1: Konsola deweloperska GroqCloud

- Zarejestruj się Zaloguj się: Odwiedzić Konsola deweloperska GroqCloud i zarejestruj się lub zaloguj na swoje konto.

- Znajdź modele Meta Llama 3.1: Przejdź do sekcji modeli i wyszukaj Meta Llama 3.1 405B. Znajdziesz również dostępne modele Instruct 70B i 8B.

- Uzyskaj klucz API: Uzyskaj bezpłatny klucz API Groq z konsoli. Ten klucz umożliwi ci interakcję z modelem.

GroqChat

Aby uzyskać dostęp publiczny, możesz użyć GroqChat:

- Odwiedź GroqChat: Iść do GroqChat aby bezpośrednio wchodzić w interakcję z Meta Llama 3.1 405B.

- Poznaj funkcje:Możliwość testowania możliwości modelu w czasie rzeczywistym, np. generowania tekstu, tłumaczeń lub odpowiadania na zapytania.

Krok 2: Konfigurowanie środowiska

Wymagania sprzętowe i programowe

- Sprzęt komputerowy: Upewnij się, że posiadasz odpowiedni sprzęt, najlepiej procesory graficzne, który sprosta wymaganiom modelu.

- Oprogramowanie: Zainstaluj niezbędne zależności oprogramowania, takie jak Python i PyTorch. Szczegółowe instrukcje konfiguracji można znaleźć w konsoli GroqCloud Dev.

Konfiguracja środowiska

- Integracja API: Zastąp istniejący standardowy klucz API kluczem API Groq.

- Ustaw adres URL bazowy: Skonfiguruj swoją aplikację tak, aby używała podstawowego adresu URL Groq do żądań API.

Krok 3: Ładowanie i uruchamianie modelu

Ładowanie modelu

- Fragmenty kodu: Użyj udostępnionych fragmentów kodu w konsoli GroqCloud Dev Console, aby załadować Meta Llama 3.1 405B do swojej aplikacji.

- Inicjalizacja:Zainicjuj model za pomocą klucza API i skonfiguruj wszystkie niezbędne parametry dla konkretnego przypadku użycia.

Uruchamianie wnioskowania

- Wnioskowanie w czasie rzeczywistym:Rozpocznij wnioskowanie w czasie rzeczywistym, wysyłając zapytania do modelu i otrzymując odpowiedzi.

- Przetwarzanie wsadowe:W przypadku większych zadań można skorzystać z przetwarzania wsadowego, aby obsługiwać wiele zapytań jednocześnie.

Krok 4: Dokładne dostrojenie do konkretnych zadań

- Dane treningowePrzygotuj zbiór danych do konkretnego zastosowania, dla którego chcesz udoskonalić model.

- Proces dostrajania:Postępuj zgodnie ze szczegółowymi instrukcjami dostarczonymi przez Meta i Groq, aby dostroić model, korzystając z nadzorowanych technik.

- Walidacja:Zweryfikuj dostrojony model, aby upewnić się, że spełnia on pożądane kryteria wydajności.

Meta Llama 3.1 405B: Testy porównawcze i wydajność

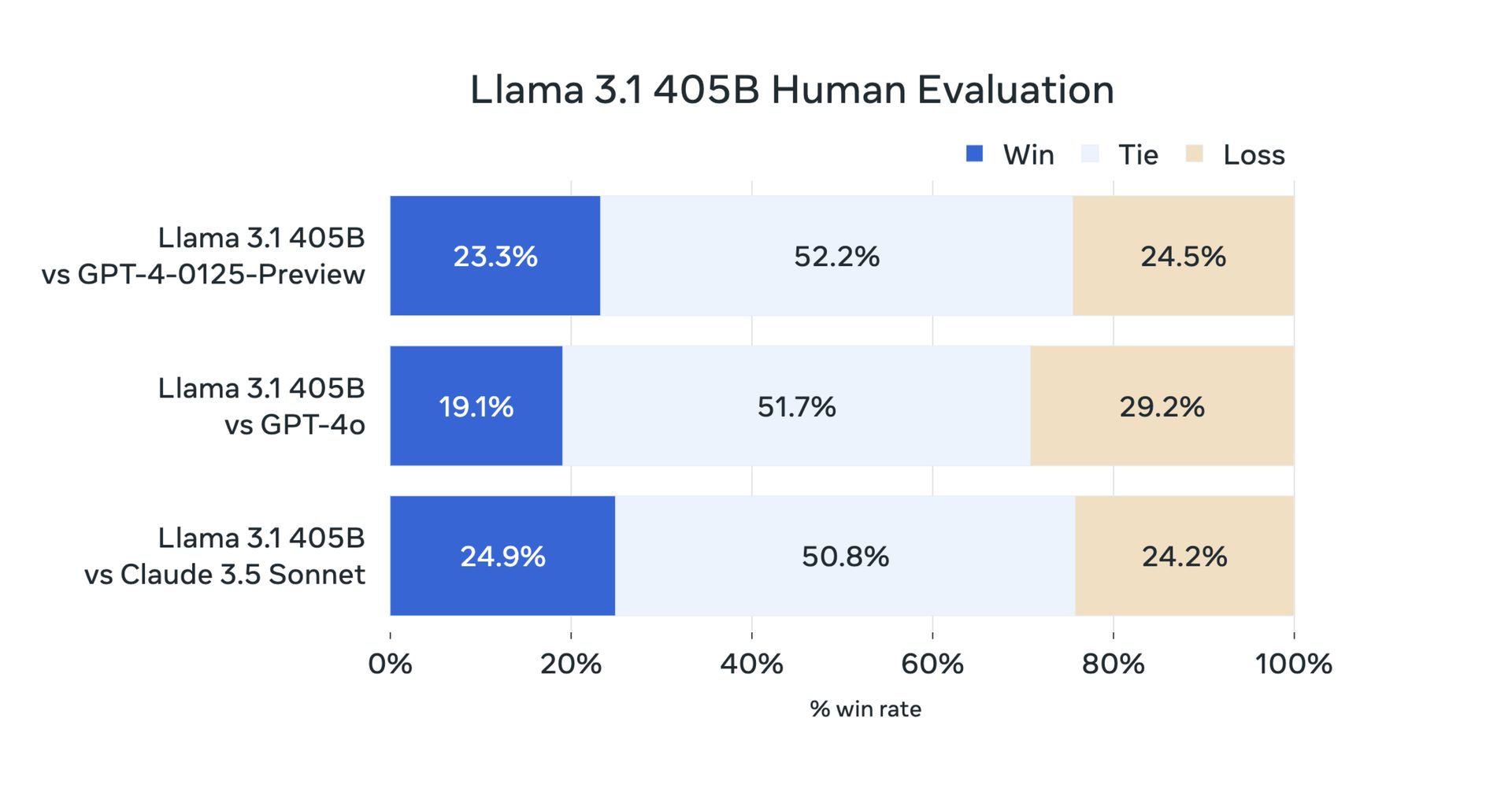

Wczoraj, ze względu na charakter open source, użytkownicy przeprowadzili testy. Jednak teraz oficjalne testy porównawcze potwierdziły, że Meta Llama 3.1 405B działa wyjątkowo dobrze w przypadku różnych zadań. Model został oceniony na ponad 150 zestawach danych porównawczych i porównany z wiodącymi modelami, takimi jak GPT-4 i Claude 3.5 Sonnet. Wyniki pokazują, że Llama 3.1 405B jest konkurencyjna w stosunku do tych najlepszych modeli i zapewnia wysoką jakość działania w rzeczywistych scenariuszach.

Przede wszystkim, oto wyniki testów porównawczych Llama 3.1 8B i Llama 3.1 70B:

| Kategoria | Reper | Lama 3.1 8B | Gemma 2 9B IT | Instrukcja Mistral 7B | Lama 3.1 70B | Instrukcja Mixtral 8x22B | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Ogólny | MMLU (bezstrzałowy, CoT) | 73,0 | 72,3 | 60,5 | 86,0 | 79,9 | 69,8 |

| Ogólny | MMLU PRO (5 strzałów, CoT) | 48.3 | – | 36,9 | 66,4 | 56.3 | 49.2 |

| Ogólny | IFEval | 80,4 | 73,6 | 57,6 | 87,5 | 72,7 | 69,9 |

| Kod | HumanEval (0 strzałów) | 72,6 | 54.3 | 40.2 | 80,5 | 75,6 | 68,0 |

| Kod | MBPP EvalPlus (podstawa) (0-strzałowy) | 72,8 | 71,7 | 49,5 | 86,0 | 78,6 | 82,0 |

| Matematyka | GSM8K (8-strzałowy, CoT) | 84,5 | 76,7 | 53.2 | 95.1 | 88.2 | 81,6 |

| Matematyka | MATEMATYKA (0 strzałów, CoT) | 51,9 | 44.3 | 13,0 | 68,0 | 54.1 | 43.1 |

| Rozumowanie | Wyzwanie ARC (0 strzałów) | 83,4 | 87,6 | 74.2 | 94,8 | 88,7 | 83,7 |

| Rozumowanie | GPQA (0-strzał, CoT) | 32,8 | – | 28,8 | 46,7 | 33.3 | 30,8 |

| Użycie narzędzi | BFCL | 76.1 | – | 60.4 | 84,8 | – | 85,9 |

| Użycie narzędzi | Ogniwo | 38,5 | 30,0 | 24.7 | 56,7 | 48,5 | 37.2 |

| Długi kontekst | ZeroSCROLLS/Jakość | 81,0 | – | – | 90,5 | – | – |

| Długi kontekst | InfiniteBench/En.MC | 65.1 | – | – | 78.2 | – | – |

| Długi kontekst | NIH/Wieloigłowy | 98,8 | – | – | 97,5 | – | – |

| Wielojęzyczny | Wielojęzyczny MGSM (0-strzał) | 68,9 | 53.2 | 29,9 | 86,9 | 71.1 | 51.4 |

A oto wyniki testów Meta Llama 3.1 405B:

| Kategoria | Reper | Lama 3.1 405B | Instrukcja Nemotron 4 340B | GPT-4 (0125) | GPT-4 Omni | Sonet Claude 3.5 |

|---|---|---|---|---|---|---|

| Ogólny | MMLU (bezstrzałowy, CoT) | 88,6 | 78,7 (nie-CoT) | 85,4 | 88,7 | 88,3 |

| Ogólny | MMLU PRO (5 strzałów, CoT) | 73,3 | 62,7 | 64,8 | 74,0 | 77,0 |

| Ogólny | IFEval | 88,6 | 85.1 | 84.3 | 85,6 | 88,0 |

| Kod | HumanEval (0 strzałów) | 89,0 | 73.2 | 86,6 | 90,2 | 92,0 |

| Kod | MBPP EvalPlus (podstawa) (0-strzałowy) | 88,6 | 72,8 | 83,6 | 87,8 | 90,5 |

| Matematyka | GSM8K (8-strzałowy, CoT) | 96,8 | 92,3 (0 strzałów) | 94,2 | 96.1 | 96,4 (0 strzałów) |

| Matematyka | MATEMATYKA (0 strzałów, CoT) | 73,8 | 41.1 | 64,5 | 76,6 | 71.1 |

| Rozumowanie | Wyzwanie ARC (0 strzałów) | 96,9 | 94,6 | 96,4 | 96,7 | 96,7 |

| Rozumowanie | GPQA (0-strzał, CoT) | 51.1 | – | 41.4 | 53,6 | 59.4 |

| Użycie narzędzi | BFCL | 88,5 | 86,5 | 88,3 | 80,5 | 90,2 |

| Użycie narzędzi | Ogniwo | 58,7 | – | 50.3 | 56.1 | 45,7 |

| Długi kontekst | ZeroSCROLLS/Jakość | 95,2 | – | – | 90,5 | 90,5 |

| Długi kontekst | InfiniteBench/En.MC | 83,4 | – | 72.1 | 82,5 | – |

| Długi kontekst | NIH/Wieloigłowy | 98.1 | – | 100,0 | 100,0 | 90,8 |

| Wielojęzyczny | Wielojęzyczny MGSM (0-strzał) | 91,6 | – | 85,9 | 90,5 | 91,6 |

Meta Llama 3.1 405B reprezentuje postęp w dziedzinie AI open-source, zapewniając programistom i badaczom potężne narzędzie do różnych zastosowań. Dzięki zaawansowanym funkcjom, solidnemu ekosystemowi i zaangażowaniu w odpowiedzialny rozwój mamy nadzieję, że Llama 3.1 405B przyniesie innowacje społecznościom AI 70B i 8B. Oto wszystko, co dla Ciebie przygotowaliśmy.

Źródło wyróżnionego obrazu: Meta-AI

Source: Wszystko co musisz wiedzieć o Meta Llama 3.1 405B