Sztuczna inteligencja (AI) poczyniła w ostatnich latach niesamowity postęp. Jednak zrozumienie, czym jest halucynacja AI i jak sobie z nią poradzić, wciąż stanowi ciągły proces dla twórców LLM.

Technologia dzisiejsza i jutrzejsza nadal fascynuje nas wszystkich, zwłaszcza jeśli chodzi o sposób, w jaki sztuczna inteligencja może rozumieć i generować ludzki język. Ogromnego postępu dokonano dzięki modelom dużego języka (LLM), programom komputerowym szkolonym na ogromnych ilościach tekstu. Te LLM mogą pisać różne rodzaje kreatywnych formatów tekstowych, takie jak wiersze, kod, skrypty, utwory muzyczne, e-maile, listy itp.

Jednak z mocą tych imponujących modeli pojawia się specyficzny problem – czasami „halucynują”.

Co to jest halucynacja AI?

Tak jak ludzie mogą wyobrażać sobie lub wymyślać rzeczy, które nie są prawdziwe, sztuczna inteligencja może zrobić coś podobnego. Halucynacje AI mają miejsce, gdy LLM tworzy tekst, który wydaje się wiarygodny, ale jest błędny pod względem faktycznym. Halucynacje te mogą obejmować drobne błędy lub całkowicie zmyślone historie i bezsensowne stwierdzenia.

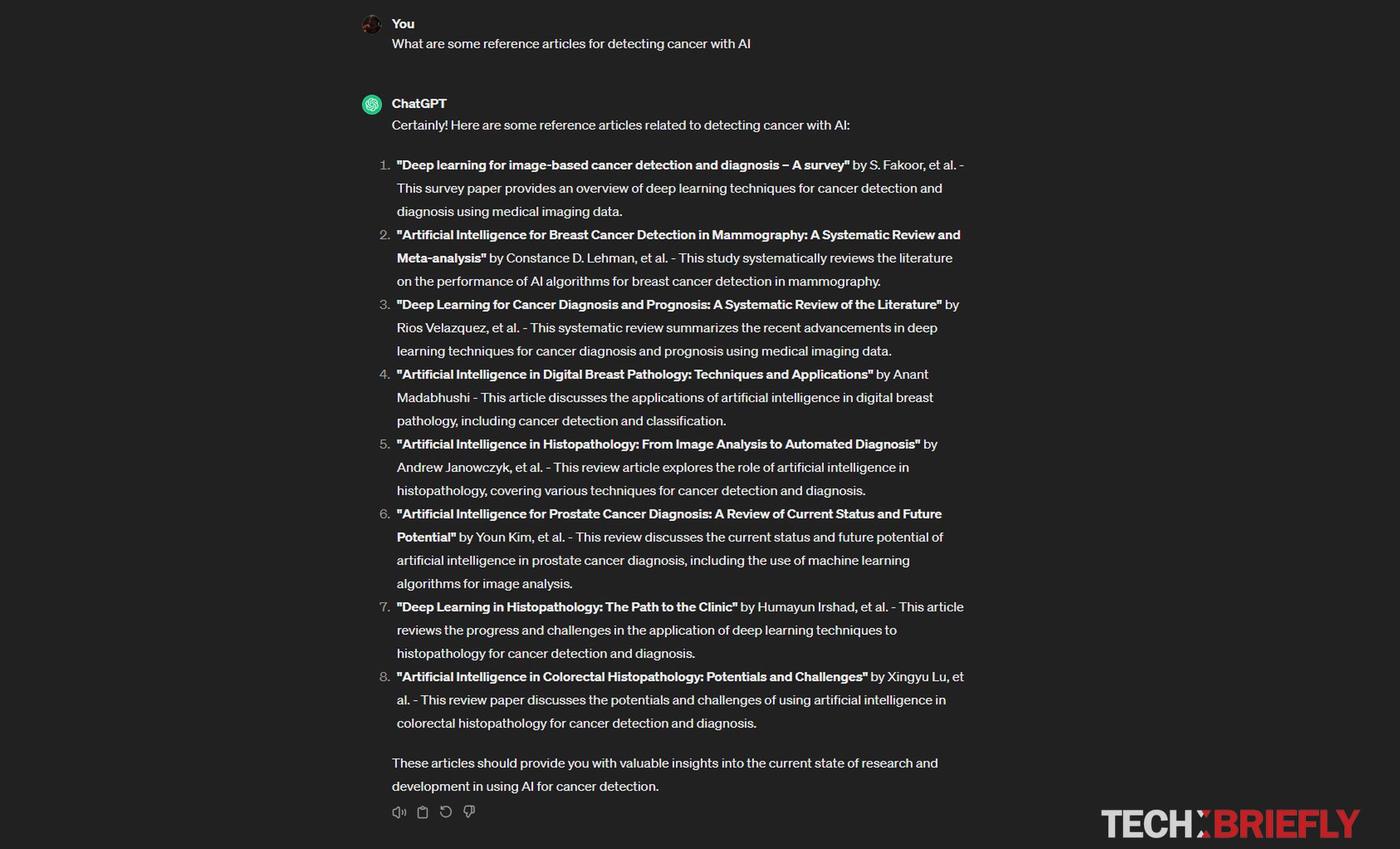

Aby lepiej zrozumieć ten problem, spójrzmy na kilka przykładów:

- Mieszanie faktów: sztuczna inteligencja poproszona o napisanie artykułu prasowego na temat wydarzenia może zawierać nieprawidłowe daty i lokalizacje lub fałszywie przedstawiać zaangażowane osoby.

- Tworzenie fałszywych informacje: sztuczna inteligencja, której zadaniem jest napisanie opisu produktu, może wymyślić funkcje, których produkt w rzeczywistości nie posiada.

- Z całą pewnością błędne: Naprawdę trudną rzeczą w przypadku halucynacji AI jest to, że często są one przedstawiane w bardzo przekonujący sposób, przez co trudno je odróżnić od prawdziwych informacji.

Dlaczego halucynacje są problemem dla LLM?

Jak widać z naszych wyjaśnień na temat halucynacji sztucznej inteligencji, stanowią one poważny problem dla osób LLM z kilku powodów. Po pierwsze, jeśli ludzie nie mogą ufać tekstowi generowanemu przez LLM, użytkownicy tracą wiarę w ogólną użyteczność i niezawodność technologii. Wyobraź sobie, że czytasz online podsumowanie wiadomości napisanej przez LLM. Jeśli podsumowanie zawiera błędy rzeczowe, możesz całkowicie zaprzestać korzystania z tego źródła. Może to stanowić poważny problem w przypadku każdej aplikacji korzystającej z LLM do generowania tekstu, takiej jak chatboty, wirtualni asystenci lub narzędzia do automatycznego tworzenia treści.

Po drugie, halucynacje AI mogą przyczynić się do rozprzestrzeniania dezinformacji. W czasach, gdy fałszywe wiadomości są już poważnym problemem, tekst wygenerowany przez sztuczną inteligencję, który wydaje się wiarygodny, można łatwo pomylić z prawdziwymi informacjami. Może to mieć negatywny wpływ na wszystko, od dyskursu publicznego po ważne procesy decyzyjne. Wyobraź sobie na przykład LLM tworzącą w mediach społecznościowych posty na temat kandydata politycznego, które zawierają fałszywe informacje.

Takie posty mogą wprowadzić wyborców w błąd i wpłynąć na wynik wyborów. To jest dokładny powód, dla którego Google wyłączył Gemini możliwość odpowiadania na zapytania związane z wyborami.

Po trzecie, firmy lub organizacje korzystające z rozwiązań LLM mogą narazić się na utratę reputacji, jeśli ich systemy sztucznej inteligencji będą wytwarzać niedokładne lub szkodliwe treści. Załóżmy, że firma korzysta z LLM do pisania opisów produktów dla swojego sklepu internetowego. Jeśli LLM wymyśli funkcje, których produkty w rzeczywistości nie mają, może to prowadzić do niezadowolenia klientów i zaszkodzić reputacji firmy.

Dlaczego zdarzają się halucynacje AI?

Masz już pewne pomysły na temat tego, czym jest halucynacja AI, ale dlaczego tak się dzieje? Na ten problem wpływa kilka czynników:

- Jak są szkoleni: LLM otrzymują ogromne ilości danych tekstowych. Dane te często zawierają błędy, uprzedzenia i nieaktualne informacje. Sztuczna inteligencja uczy się na podstawie tych danych tak samo, jak na podstawie prawidłowych informacji.

- Rozumienie vs tworzenie: Studenci LLM są dobrzy w rozumieniu wzorców językowych, ale nie zawsze mają solidną wiedzę na temat pojęć i logiki ze świata rzeczywistego. Mogą stworzyć coś, co brzmi wiarygodnie, choć w rzeczywistości nie jest to prawdą.

- W poszukiwaniu płynności: LLM mają na celu tworzenie tekstu, który brzmi naturalnie i jak ludzki. Czasami oznacza to „uzupełnienie luk”, w których mogą występować luki w wiedzy sztucznej inteligencji. Te wypełnione puste miejsca mogą prowadzić do tworzenia treści przez sztuczną inteligencję.

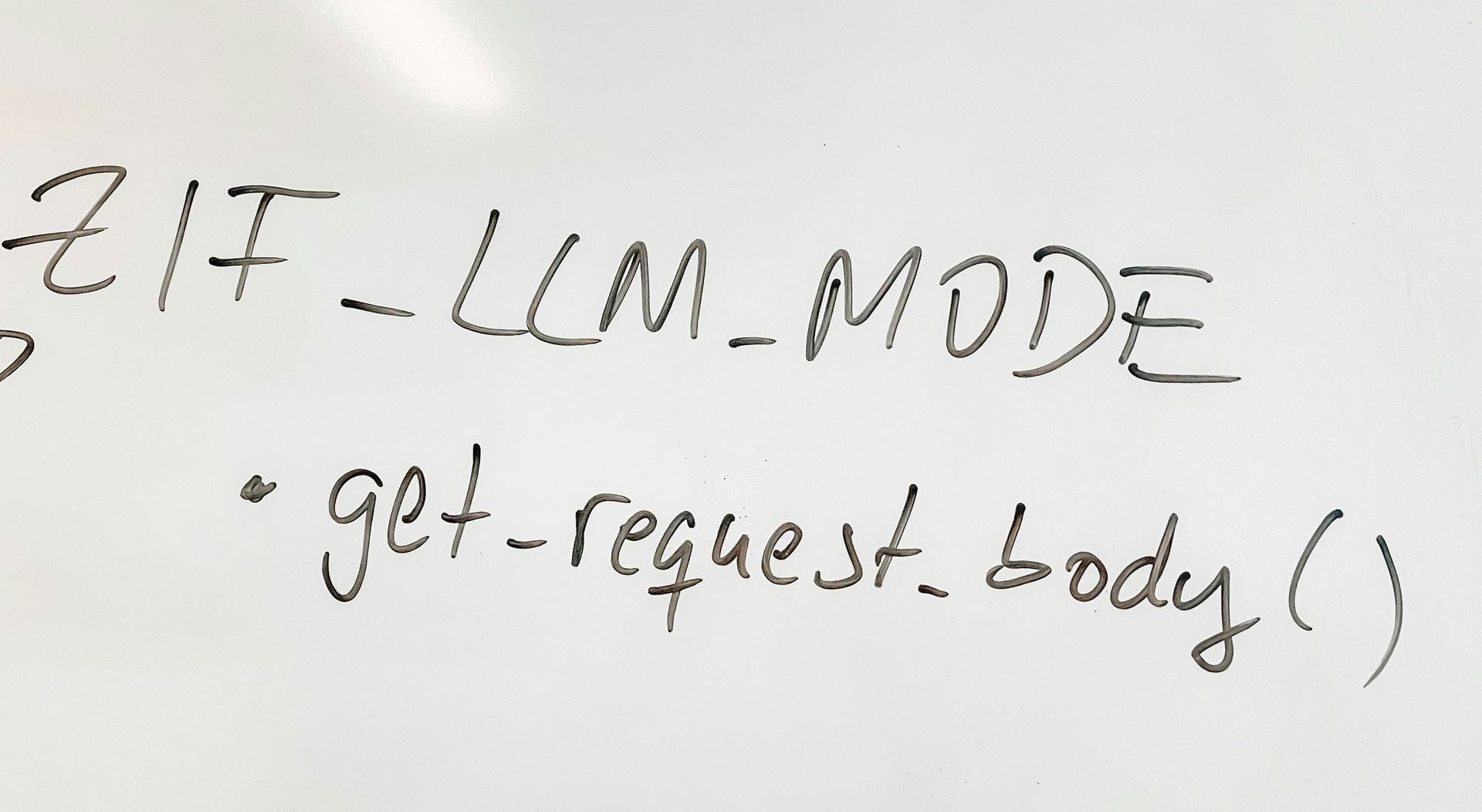

Co się robi, aby rozwiązać ten problem?

Naukowcy i programiści należący do społeczności sztucznej inteligencji aktywnie pracują nad sposobami ograniczenia halucynacji związanych ze sztuczną inteligencją.

Niektóre z podejść obejmują:

- Lepsze dane treningowe: Tworzenie starannie dobranych zbiorów danych, które są mniej podatne na błędy i uprzedzenia, co prowadzi do poprawy zachowania sztucznej inteligencji.

- Sprawdzanie faktów: Opracowanie technik porównywania tekstu wygenerowanego przez sztuczną inteligencję z wiarygodnymi źródłami, zapewniając jego dokładność.

- Wyjaśnialność: Projektowanie LLM, które mogą wyjaśnić proces rozumowania, co ułatwia dostrzeżenie potencjalnych błędów

- Współpraca człowieka i sztucznej inteligencji: Tworzenie systemów, w których ludzie i sztuczna inteligencja współpracują, co ułatwia identyfikację i korygowanie halucynacji.

Poza tym Jensen Huang z Nvidii twierdzi, że halucynacje związane ze sztuczną inteligencją można wyleczyć w ciągu najbliższych 5 lat.

Zatem halucynacje związane ze sztuczną inteligencją są złożonym wyzwaniem, ale należy je pokonać, jeśli LLM chcą osiągnąć swój pełny potencjał. W miarę jak technologie zmniejszające halucynacje stają się coraz bardziej wyrafinowane, obiecują, że LLM staną się znacznie bardziej godnym zaufania i wartościowym narzędziem do zadań związanych z komunikacją, kreatywnością i wiedzą.

Autor wyróżnionego obrazu: vackground.com/Usuń rozpryski

Source: Co to jest halucynacja AI i dlaczego jest to tak ważna sprawa dla przyszłości LLM?